Vorbemerkung des Übersetzers: Dieser Beitrag geht ausführlich auf meine Ausführungen in Kurzform ein, die man hier als Ergänzung zu diesem Artikel betrachten kann. – Alle Hervorhebungen im Original. – Ende Vorbemerkung

Wann immer die Vorhersagen von Klimamodellen erwähnt werden, gibt es hier und anderswo in den Blogs eine Menge „Modell-Bashing“. Dieser Aufsatz ist ein sehr ausführlicher Versuch, den eher reflexartigen Teil dieses wiederkehrenden Phänomens abzukühlen.

Wir alle verwenden Modelle, um Entscheidungen zu treffen, wobei die meisten von uns einfach zusammengewürfelte mentale Modelle im Sinne von: „Ich sehe keine Autos auf der Straße, ich höre keine Autos auf der Straße, ich habe zweimal in beide Richtungen geschaut, also sagt mir mein mentales Modell, dass ich die Straße jetzt sicher überqueren werde.“ Ihr kleines „sicheres Überqueren der Straße“-Modell ist durchaus nützlich und (sofern keine unbekannten oder anderweitig nicht berücksichtigten Beweise vorliegen) verlässlich für die persönliche Sicherheit beim Überqueren der Straße.

Es ist in keiner Weise nützlich oder richtig zu sagen: „Alle Modelle sind Schrott“.

Die Modelle, über die wir hier auf dieser Website sprechen, sind „numerische Klimamodelle“ [oder eine breitere Suche nach Referenzen hier], die üblicherweise auf Supercomputern laufen. Die NASA sagt Folgendes dazu:

Klimamodellierer lassen den von ihnen geschriebenen Klimasimulations-Computercode auf den Supercomputern des NASA Center for Climate Simulation (NCCS) laufen. Bei der Durchführung ihrer mathematischen Simulationen unterteilen die Klimamodellierer die Atmosphäre in 3D-Gitter. Innerhalb jeder Gitterzelle berechnet der Supercomputer physikalische Klimawerte wie Windvektoren, Temperatur und Feuchtigkeit. Nachdem die Bedingungen anhand realer Beobachtungen initialisiert wurden, wird das Modell um einen „Zeitschritt“ vorwärts bewegt. Mithilfe von Gleichungen werden die Klimawerte neu berechnet, wodurch eine projizierte Klimasimulation entsteht.

Wikipedia erklärt dazu:

Ein allgemeines Zirkulationsmodell (GCM) ist eine Art von Klimamodell. Es verwendet ein mathematisches Modell der allgemeinen Zirkulation einer planetarischen Atmosphäre oder eines Ozeans. Es verwendet die Navier-Stokes-Gleichungen auf einer rotierenden Kugel mit thermodynamischen Termen für verschiedene Energiequellen (Strahlung, latente Wärme). Diese Gleichungen bilden die Grundlage für Computerprogramme, mit denen die Erdatmosphäre oder die Ozeane simuliert werden. Atmosphärische und ozeanische GCMs (AGCM und OGCM) sind neben den Komponenten für Meereis und Landoberflächen die wichtigsten Komponenten.

Ich bin offen für andere Definitionen für das grundlegende GCM. Es gibt natürlich Hunderte von verschiedenen „Klimamodellen“ unterschiedlicher Art und Verwendung.

Aber lassen Sie uns nur das allgemeine Thema betrachten, das die Grundlage für Behauptungen bildet, die mit dem Satz beginnen: „Klimamodelle zeigen, dass…“

Hier sind ein paar Beispiele aus einer einfachen Google-Suche zu diesem Satz:

Klimamodelle zeigen, dass der Anstieg des Meeresspiegels durch thermische Expansion unvermeidlich ist (hier)

Globale Klimamodelle zeigen, dass das arktische Meereis zumindest für einen Teil des Jahres zu verschwinden droht (hier)

Klimamodelle zeigen, dass die globale Erwärmung bis zum Jahr 2100 um 1,8 bis 4,4°C zunehmen könnte (hier)

Sowohl historische Daten als auch zukünftige Klimamodelle zeigen, dass die globale Erwärmung (ungefähr) direkt proportional zum Anstieg der CO₂-Konzentration ist (hier)

Alle Klimamodelle zeigen, dass die Zugabe von Kohlendioxid in die Atmosphäre zu einer globalen Erwärmung und zu Veränderungen bei den Niederschlägen führen wird (hier)

Klimamodelle zeigen, dass Kapstadt eine trockenere Zukunft bevorsteht (hier)

Versuchen wir es mal mit „die Klimawissenschaft prophezeit…“:

Die Klimawissenschaft prophezeit, dass sich die Landgebiete der Welt schneller erwärmen sollten als die Meere, und unsere Temperaturdaten bestätigen dies (hier)

Die Muster extremer Wetterereignisse in den Vereinigten Staaten verändern sich, und die Klimawissenschaft prophezeit weitere Veränderungen (hier)

Es gibt zahllose Beispiele. Aber fragen wir uns: „Was meinen sie, wenn sie sagen ‚Die Klimawissenschaft prophezeit…‘?“

Im Allgemeinen meinen sie eine der beiden folgenden Aussagen:

1) Dass irgendein Klimawissenschaftler oder der IPCC oder irgendeine Gruppe in irgendeinem Klimabericht behauptet [oder allgemein angenommen wird, dass er/sie behauptet hat, was sehr oft nicht genau der Fall ist], dass ein solches zukünftiges Ereignis/eine solche Bedingung eintreten wird.

2) Ein Klimamodell [oder ein einzelner Durchlauf eines Klimamodells oder eine bestimmte Anzahl von Klimamodellausgaben, die gemittelt wurden] hat prophezeit/projiziert, dass ein solches zukünftiges Ereignis/eine solche zukünftige Bedingung eintreten wird.

Man beachte, dass der erste Fall oft selbst auf dem zweiten beruht.

Die Ergebnisse von Klimamodellen pauschal abzulehnen, ist genauso dumm, wie den gesamten Klimaskeptizismus pauschal abzulehnen. Ein bisschen Intelligenz und Verständnis ist erforderlich, um aus beidem schlau zu werden. Es gibt einige Punkte/Behauptungen von Klimaskeptikern, denen ich nicht zustimme, und es gibt Behauptungen zur Klimakrise, denen ich nicht zustimme.

Aber ich weiß, warum ich nicht zustimme.

Warum ich die meisten Klimamodellvorhersagen oder Projektionen zukünftiger Klimazustände nicht akzeptiere

Vor Jahren, am 5. Oktober 2016, schrieb ich Lorenz validiert, der auf Judith Currys Blog Climate Etc. veröffentlicht wurde. Es ist eine interessante Lektüre und wichtig genug, um sie erneut zu lesen, wenn man wirklich neugierig ist, warum die numerische Klimamodellierung so schwerwiegende Probleme hat, dass sie von vielen, mich eingeschlossen, als nur zufällig gültige langfristige Prognosen angesehen wird. Ich sage „zufällig“ in demselben Sinne, in dem eine stehengebliebene Uhr zweimal am Tag die richtige Zeit anzeigt, oder vielleicht wie eine falsch eingestellte Uhr, die mit einer leicht falschen Geschwindigkeit läuft und nur gelegentlich und zufällig die richtige Zeit anzeigt.

Ich behaupte nicht, dass ein numerisches Klimamodell niemals eine korrekte Vorhersage machen kann und wird.

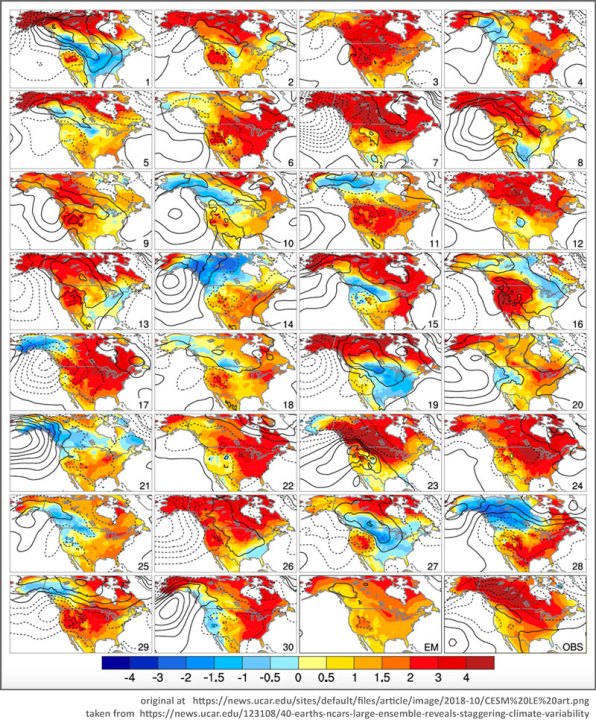

Jennifer Kay und Clara Deser, beide von der University of Colorado Boulder und mit dem NCAR/UCAR [National Center for Atmospheric Research, University Corporation for Atmospheric Research] verbunden, haben zusammen mit 18 anderen im Jahr 2016 Experimente mit Klimamodellen durchgeführt und eine wunderbare Studie mit dem Titel: „The Community Earth System Model (CESM) Large Ensemble Project: A Community Resource for Studying Climate Change in the Presence of Internal Climate Variability“ geschrieben.

Die vollständige Studie steht hier zum Download bereit [.pdf].

Folgendes haben sie getan (in Kurzform):

„Um die möglichen Auswirkungen winziger Störungen des Klimas zu erforschen – und um ein umfassenderes Verständnis der möglichen Klimaschwankungen zu erlangen – leiteten Deser und ihre Kollegin Jennifer Kay, eine Assistenzprofessorin an der University of Colorado Boulder und Gastwissenschaftlerin am NCAR, ein Projekt, bei dem das NCAR-basierte Community Earth System Model (CESM) 40 Mal von 1920 bis zum Jahr 2100 durchlaufen wurde. Bei jeder Simulation veränderten die Wissenschaftler die Ausgangsbedingungen des Modells nur geringfügig, indem sie die globale atmosphärische Temperatur um weniger als ein Billionstel eines Grades anpassten und damit eine einzigartige und chaotische Kette von Klimaereignissen in Gang setzten.“ [Quelle]

Worauf beziehen sich Deser und Kay hier?

„Es ist der sprichwörtliche Schmetterlings-Effekt“, sagt Clara Deser… “Könnte ein Schmetterling, der in Mexiko mit den Flügeln schlägt, diese kleinen Bewegungen in der Atmosphäre auslösen, die zu großräumigen Veränderungen der atmosphärischen Zirkulation führen?“

Anmerkung des Autors: Die Antwort auf die genaue ursprüngliche Frage von Edward Lorenz lautet „Nein“, und zwar aus vielen Gründen, die mit der Größe und Viskosität der Atmosphäre zu tun haben und über die endlos gestritten wird. Aber der Grundsatz „extreme Empfindlichkeit gegenüber den Anfangsbedingungen“ ist wahr und richtig und wurde in der Studie von Deser und Kay in der praktischen Anwendung in einem echten Klimamodell nachgewiesen.

Was geschah, als Deser und Kay das Community Earth System Model (CESM) 40 Mal laufen ließen und dabei genau denselben Modelllauf vierzig Mal wiederholten, wobei sie alle dieselben Eingaben und Parameter verwendeten, mit Ausnahme einer Eingabe: der globalen atmosphärischen Temperatur? Diese Eingabe wurde bei jedem Durchlauf geändert durch:

weniger als ein Billionstel eines Grades

oder

< 0.0000000000001 °C

Und diese eine Änderung führte zu den Projektionen für „Wintertemperaturtrends (in Grad Celsius) für Nordamerika zwischen 1963 und 2012“, die als Grafiken dargestellt sind:

Beachten Sie zunächst, wie unterschiedlich die 30 Projektionen sind. Vergleichen Sie Nr. 11 mit Nr. 12 direkt daneben. In Nr. 11 ist der Norden Kanadas und Alaskas kalt, während es in Nr. 12 im Norden Kanadas und Alaskas heiß ist. Dann schauen Sie sich Nr. 28 an.

Vergleichen Sie Nr. 28 mit OBS (Beobachtungen, die Realität, die Wirklichkeit, das, was tatsächlich stattgefunden hat). Denken Sie daran, dass es sich nicht um Temperaturen, sondern um Temperaturtrends über 50 Jahre hinweg handelt. Nicht Wetter, sondern Klima.

Schauen Sie sich nun EM an, neben OBS in der unteren Reihe. EM = Ensemble Mean (Ensemble-Mittelwert) – sie haben die Ergebnisse von 30 Durchläufen zu einem einzigen Ergebnis GEMITTELT.

Das Experiment sollte zeigen, ob numerische Klimamodelle extrem empfindlich auf die Anfangsbedingungen reagieren oder nicht. Sie änderten eine einzige Eingabe um einen verschwindend geringen Betrag – weit unterhalb der tatsächlichen Messgenauigkeit in der realen Welt (oder unserer Fähigkeit, die Lufttemperaturen zu messen). Dieser Betrag? Ein Billionstel Grad Celsius – 0,0000000000001 °C. Um ganz fair zu sein, ist die Abweichung geringer als das.

In dem Artikel erklären die Autoren, dass sie sich der extremen Abhängigkeit von den Anfangsbedingungen bei der numerischen Klimamodellierung durchaus bewusst sind. In gewisser Weise ist das sogar der Grund für ihr Experiment. Sie wissen, dass sie chaotische Ergebnisse (wie im Bereich der Chaos-Theorie) erhalten werden. Und sie erhalten tatsächlich chaotische Ergebnisse. Keiner der 30 Durchläufe entspricht der Realität. Die 30 Ergebnisse unterscheiden sich alle in erheblicher Weise. Der Ensemble-Mittelwert unterscheidet sich erheblich von den Beobachtungen und stimmt nur darin überein, dass die Winter im Allgemeinen etwas milder sein werden, weil den Modellen ausdrücklich gesagt wird, dass es wärmer wird, wenn die CO₂-Konzentrationen steigen (was der Fall war).

Aber was sie als chaotische Ergebnisse bezeichnen, ist die interne Klimavariabilität.

Das ist ein großer Irrtum. Ihre hübschen kleinen Bilder stellen die numerisch chaotischen Ergebnisse nichtlinearer dynamischer Systeme dar, die durch mathematische Formeln dargestellt werden (von denen die meisten selbst sehr empfindlich auf die Anfangsbedingungen reagieren), wobei jedes Ergebnis bei jedem nachfolgenden Zeitschritt ihres Klimamodells in die Formeln zurückgeführt wird.

Edward Lorenz zeigte in seiner bahnbrechenden Studie „Deterministic Nonperiodic Flow“, dass numerische Wettermodelle Ergebnisse liefern, die extrem empfindlich auf die Anfangsbedingungen reagieren, und je weiter in die Zukunft man sie laufen lässt, je mehr Zeitschritte berechnet werden, desto größer und breiter wird die Streuung der chaotischen Ergebnisse.

Was genau hat Lorenz gesagt? „Zwei Zustände, die sich um unmerkliche Beträge unterscheiden, können sich schließlich zu zwei beträchtlich unterschiedlichen Zuständen entwickeln … Wenn es also irgendeinen Fehler bei der Beobachtung des gegenwärtigen Zustands gibt – und in jedem realen System scheinen solche Fehler unvermeidlich zu sein – kann eine akzeptable Prophezeiung eines momentanen Zustands in der fernen Zukunft durchaus unmöglich sein….. Angesichts der unvermeidlichen Ungenauigkeit und Unvollständigkeit von Wetterbeobachtungen scheint eine präzise Vorhersage über sehr weite Entfernungen nicht existent zu sein.

Diese numerischen Klimamodelle können nicht versagen, wenn sie keine genauen langfristigen Klimazustände prophezeien oder projizieren. Diese Situation kann nicht vermieden werden. Sie kann nicht „umgangen“ werden. Sie kann nicht durch immer feinere Gitter gelöst werden.

Nichts kann die Tatsache korrigieren, dass die Empfindlichkeit gegenüber den Anfangsbedingungen – das Hauptmerkmal der Auswirkungen der Chaostheorie auf die Klimamodelle – dazu führt, dass die Modelle die Fähigkeit verlieren, langfristige zukünftige Klimazustände zu prophezeien.

Deser und Kay zeigen dies in ihrer Studie von 2016 und in nachfolgenden Studien deutlich auf.

Was bedeutet das für die praktische Arbeit in der Klimawissenschaft?

Das bedeutet genau das, was Lorenz vor all den Jahren festgestellt hat – um den IPCC TAR zu zitieren: „Das Klimasystem ist ein gekoppeltes nichtlineares chaotisches System, und daher ist die langfristige Prophezeiung zukünftiger Klimazustände nicht möglich.“

Deser und Kay bezeichnen die in ihrer Studie gefundenen chaotischen Ergebnisse als „interne Klimavariabilität“. Das ist völlig, total, absolut und grandios falsch.

Die chaotischen Ergebnisse, die sie als chaotische Ergebnisse aufgrund der Empfindlichkeit gegenüber den Ausgangsbedingungen bezeichnen, sind nicht mehr und nicht weniger als chaotische Ergebnisse aufgrund der Empfindlichkeit gegenüber den Ausgangsbedingungen. Diese Variabilität ist numerisch – die Zahlen variieren, und sie variieren, weil es Zahlen sind [und nicht das Wetter und nicht das Klima].

Die in Klimamodellen variierenden Zahlen variieren chaotisch, weil die Zahlen aus der Berechnung nichtlinearer partieller Differentialgleichungen stammen, wie z. B. die Navier-Stokes-Gleichungen, ein System partieller Differentialgleichungen, das die Bewegung eines Fluids im Raum beschreibt wie z. B. in der Atmosphäre oder den Ozeanen. Die Navier-Stokes-Gleichungen spielen in numerischen Klimamodellen eine wichtige Rolle. „Das offene Problem der Existenz (und Glättung) von Lösungen der Navier-Stokes-Gleichungen ist eines der sieben Millenniumspreis-Probleme in der Mathematik“ – für die Lösung des gestellten Problems gibt es $ 1.000.000,00. Aus diesem Grund wird in Modellen eine linearisierte Version der Navier-Stokes-Gleichungen verwendet.

Wie sieht das nun in den heutigen Klimamodellen aus – welche Verfahren werden verwendet, um diese Hindernisse für langfristige Vorhersagen zu umgehen?

„Offensichtlich würde ein dynamisches System, das zu Beginn keine explizite Zufälligkeit oder Ungewissheit aufweist, nach ein paar Zeitschritten unvorhersehbare Entwicklungen zeigen, wenn sich die Anfangswerte nur geringfügig ändern. Wenn man sieht, wie selbst die Lorenz-Gleichungen (wie sie im Laufe der Zeit bekannt geworden sind) chaotische Züge aufweisen, kann man sich vorstellen, in welchem (vermutlich kurzen) Ausmaß die Navier-Stokes-Gleichungen auf einem Gitter mit einer Million Punkten vorhersagbar sein würden. Wie bereits erwähnt, ist dies der Grund, warum die heutigen Atmosphärenmodelle eine Reihe von vereinfachenden Annahmen, Linearisierungen und statistischen Verfahren verwenden, um brauchbarere Systeme zu erhalten.“ [Quelle – oder download.pdf]

Mit anderen Worten: Das Mantra, dass Klimamodelle korrekt und verlässlich sind und genaue langfristige Prognosen liefern, weil sie auf bewährter Physik basieren, ist falsch – die Physik wird mit subjektiven Annahmen behandelt, welche die Physik „vereinfachen“, Linearisierungen der bekannten mathematischen Formeln (die das Unlösbare lösbar machen) und dann statistischen Verfahren unterworfen, um „ brauchbarere Systeme“ zu erhalten.

Natürliche Variabilität kann nur in der Vergangenheit gesehen werden. Es ist die Variabilität in der Natur – der realen Welt – in dem, was wirklich passiert ist.

Das Wetter und das Klima werden sich in der Zukunft verändern. Und wenn wir darauf zurückblicken, werden wir die Variabilität sehen.

Aber was in numerischen Klimamodellen passiert, ist das Gegenteil der natürlichen Variabilität. Es ist numerisches Chaos. Dieses numerische Chaos ist keine natürliche Klimavariabilität – und auch keine interne Klimavariabilität.

Aber wie können wir das numerische Chaos, das in den Klimamodellen zu sehen ist, von dem Chaos trennen, das in dem gekoppelten nichtlinearen chaotischen System, welches das Klima der Erde ist, deutlich sichtbar ist?

(Und jetzt muss ich auf meine persönliche Meinung zurückgreifen – eine fundierte Meinung, aber letztendlich nur eine Meinung):

Wir können es nicht!

Ich kann (und habe) Bilder und Diagramme der chaotischen Ausgabe verschiedener Formeln zeigen, die numerisches Chaos demonstrieren. Sie können sich meine Chaos-Serie hier ansehen, indem Sie nach unten scrollen und sich die Bilder ansehen.

Es ist klar, dass die gleiche Art von chaotischen Merkmalen in allen Arten von realen physikalischen Systemen auftritt. Bevölkerungsdynamik, Luftströmung, Krankheitsausbreitung, Herzrhythmen, Gehirnwellenfunktionen….fast alle dynamischen Systeme der realen Welt sind nichtlinear und weisen Aspekte des Chaos auf. Und natürlich ist auch das Klima der Erde im Sinne der Chaostheorie chaotisch.

Aber bedeutet das nicht, dass das numerische Chaos in den Klimamodellen eine interne oder natürliche Variabilität ist? Nein, das bedeutet es nicht.

Eine perfekt berechnete Flugbahn einer Kanonenkugel, basierend auf den besten Newtonschen Gesetzen, wird keine Burgmauer zum Einsturz bringen. Es ist nur ein Gedanke, eine Beschreibung. Die aus den Formeln berechnete Energie ist nicht real. Die beschriebene Kanonenkugel ist kein Ding. Und um ein klischeehaftes Sprichwort zu verwenden: Die Karte ist nicht das Gebiet.

Ebenso ähnelt das numerische Chaos, das von Klimamodellen erzeugt wird, in seiner Erscheinung dem Chaos, das wir im Klima der realen Welt beobachten, aber es ist nicht dieses Chaos und nicht das zukünftige Klima. Lorenz’ „Entdeckung“ des numerischen Chaos führte zu den Entdeckungen, dass die Chaostheorie auf dynamische Systeme in der realen Welt anwendbar ist.

Nehmen wir ein Beispiel aus den Nachrichten dieser Woche:

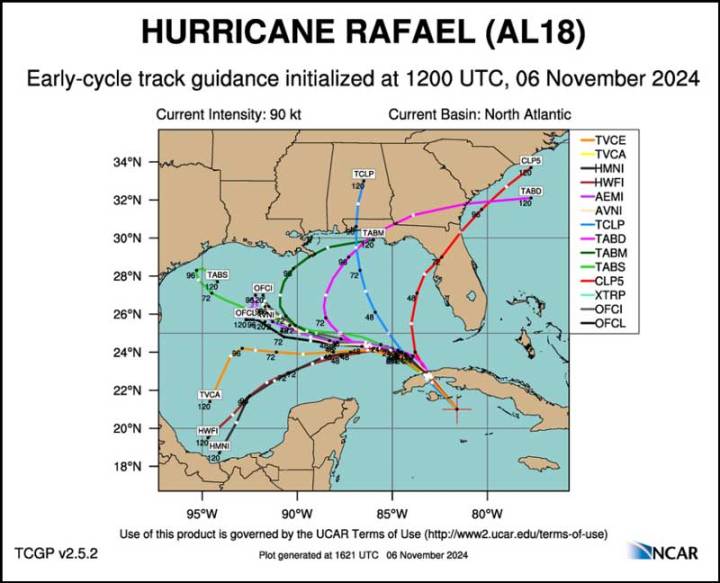

Der Weg des Hurrikans Rafael hat sich laut Tracker-Modellen stark verändert:

Dargestellt sind die von unseren führenden Hurrikan-Modellen projizierten Pfade mit Stand 12:00 UTC am 6. November 2024. Der unordentliche schwarze Fleck direkt über Westkuba ist der 24-Stunden-Punkt, an dem die Modelle beginnen, stark auseinander zu laufen.

Warum weichen sie voneinander ab? All das oben Genannte – alles in diesem Essay – diese Hurrikan-Zugprojektionen sind ein anschauliches Beispiel dafür, was Chaos mit Wettervorhersagen und damit auch mit Klimavorhersagen macht. Schon 24 Stunden im Voraus beginnen alle Projektionen auseinander zu laufen. In 72 Stunden könnte sich der Hurrikan irgendwo zwischen nordwestlich von Yucatan und bereits an der Küste Floridas befinden.

Wenn Sie ein Haus in Galveston, Texas hätten, was würden Ihnen diese Projektionen nützen? Wäre es nützlicher, wenn NCAR die Pfade „gemittelt“ hätte, um einen „Ensemble-Mittelwert“ zu ermitteln?

Zurück zum ersten Bild der 30 projizierten Wintertemperaturtrends, einer sehr vagen Messgröße: Ist der EM (Ensemble-Mittelwert) dieser speziellen Modellläufe, erstellt mit einer der vom Copernicus Climate Change Service vorgeschlagenen Verfahren, genauer als alle anderen Zukunftsprognosen? Oder ähnelt er nur zufällig den Beobachtungen?

Kommentar des Autors:

Dies ist kein einfaches Thema. Es ist umstritten. Klimaforscher kennen Lorenz, Chaos, Empfindlichkeit gegenüber Anfangsbedingungen, nichtlineare dynamische Systeme und wissen, was das für Klimamodelle bedeutet. Der IPCC wusste es früher, ignoriert die Fakten aber heute.

Einige Kommentatoren hier werden schreien: „Es ist kein Problem der Anfangsbedingungen, sondern ein Randproblem“ – als ob damit alles in Ordnung wäre. Sie können hier sehr ausführlich etwas darüber lesen. Vielleicht schreibe ich in einem zukünftigen Essay über diesen Versuch, der Realität auszuweichen.

Ich werde mit einem Verweis auf die Kommentare des eklektischen R G Brown schließen, die ich hier gesponsert habe und in denen er sagt:

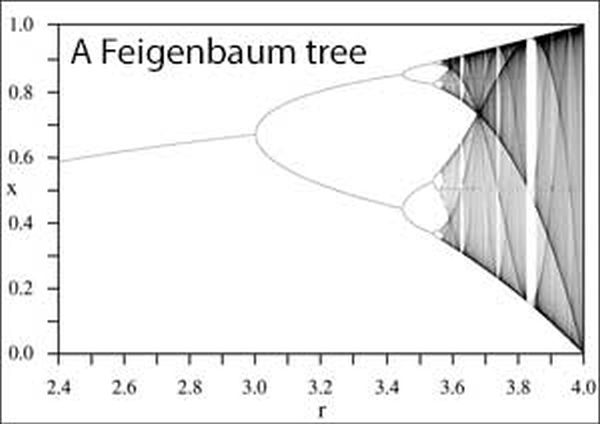

„Was niemand zugibt, ist, dass die aktuellen Klimamodelle trotz ihrer rechnerischen Komplexität und ihres enormen Umfangs und Aufwands noch immer nicht mehr als Spielzeuge sind, unzählige Größenordnungen von der Integrationsskala entfernt, bei der wir eine vernünftige Hoffnung auf Erfolg haben könnten. Sie werden hemmungslos verwendet, um zahllose Klimaverläufe zu erzeugen, von denen keine besonders dem Klima ähnelt, und dann werden sie auf eine Art gemittelt, die eine absolute statistische Obszönität darstellt, als ob der linearisierte Durchschnitt eines Feigenbaum-Baums chaotischen Verhaltens ein guter Prädiktor des Verhaltens eines chaotischen Systems wäre! … Das ist nicht nur dumm, es ist mehr als dumm. Es ist buchstäblich ein Verrat an den Wurzeln der gesamten Disziplin für Manna.“

Und das sage ich auch!

Übersetzt von Christian Freuer für das EIKE

Der Beitrag Warum numerische Modelle bei der langfristigen Klima-Prognose versagen erschien zuerst auf EIKE – Europäisches Institut für Klima & Energie.