Kategorie: Nachrichten

Corona-Protokolle aus Deutschland bestätigen Maßnahmenkritiker – auch in Österreich

Die freigeklagten RKI-Protokolle belegen eindrücklich, dass all jene Argumente, die Maßnahmenkritiker in den Corona-Jahren vorbrachten, auch den Wissenschaftlern beim RKI bekannt waren. Die Politik ignorierte das und erhob die Kritikpunkte zu Verschwörungstheorien. Die GGI-Initiative mahnt an, dass es sich in Österreich ganz ähnlich verhalten haben dürfte. Nur eine lückenlose Aufarbeitung kann verhindern, dass sich derartige Vorgänge wiederholen.

RKI Files – brisante Corona-Protokolle aus Deutschland

Presseaussendung der GGI-Initiative am 26.03.2024

Multipolar, ein unabhängiges Medium aus Deutschland, hat geheime Dokumente des RKI freigeklagt. Die Inhalte offenbaren brisante Details, wie offenkundig politisch und evidenzbefreit das deutsche Maßnahmenregime ablief. Die Grünen für Grundrechte und Informationsfreiheit (GGI) zeigen anhand weiterer Beispiele auf, dass KritikerInnen mit ihren Fragen richtig lagen und zu Unrecht zensiert und diskreditiert wurden. Man kann davon ausgehen, dass dies genauso auf Österreich zutrifft. Wir fordern weiterhin eine ehrliche Aufarbeitung der Corona-Politik.

Unabhängige Medien decken auf

Das unabhängige – fälschlicherweise oft als rechts bezeichnete – deutsche Multipolar-Magazin hat bislang unter Verschluss gehaltene Protokolle des Krisenstabs am Robert Koch Institut (RKI) nach einer Klage erhalten. Obwohl viele Passagen geschwärzt wurden, enthalten die Dokumente interessante Einblicke. Multipolar selbst hat einen der brisantesten Aspekte gezeigt, nämlich die nicht näher begründete Hochskalierung der pandemischen Risikobewertung auf das Signal einer bislang unbekannten Person hin. [1]

Mit dem ZDF hat auch ein deutsches Leitmedium über die Dokumente berichtet. Obwohl man versucht, die erwähnte Hochskalierung herunterzuspielen, werden Kritik an FFP2-Masken und Privilegien durch Impfzertifikate zitiert. [2]

Der Krisenstab wurde im Jänner 2020 eingerichtet. Die Tagesordnungen und Sitzungsprotokolle erstrecken sich von da an bis Ende April 2021 und werden von Multipolar vollständig zur Verfügung gestellt. [3] Alle Dokumente von über 2518 Seiten hier zum Download erhältlich.

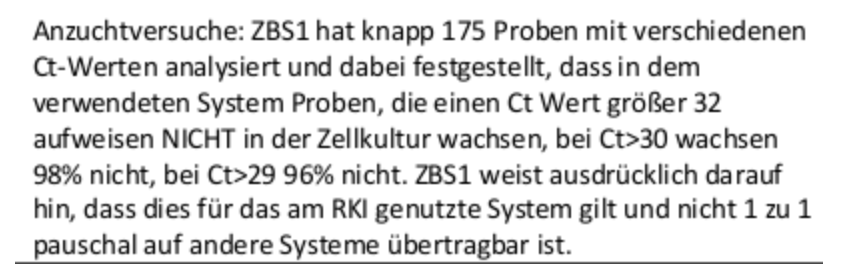

Was wusste das RKI? – Kalibrierung von PCR-Test

Diverse Inhalte werden auf Social Media auf und ab diskutiert. Im Rahmen dieser Serie zur Großen Aufarbeitung haben wir Grüne für Grundrechte und Informationsfreiheit (GGI) bereits viele zweifelhafte Aspekte und Logikfehler aufgezeigt. Zum Thema PCR-Test haben wir neben der Bedeutungslosigkeit hoher CT-Werte auch die nicht vorhandene Kalibrierung auf (theoretisch) infektiöses Potenzial mittels Viruskultur kritisiert. [4]

Am RKI hat man über beide Aspekte Bescheid gewusst. In der Sitzung vom 22.05.2020 ist das Ergebnis einer entsprechenden Untersuchung nachzulesen. Darin bestätigt sich die Faustregel, dass außerhalb eines Fensters von 10 Tagen nach Symptombeginn und CT-Wert von 30 so gut wie keine Chance auf positive Viruskultur besteht. Eine Infektiösität ist daher nahezu ausgeschlossen.

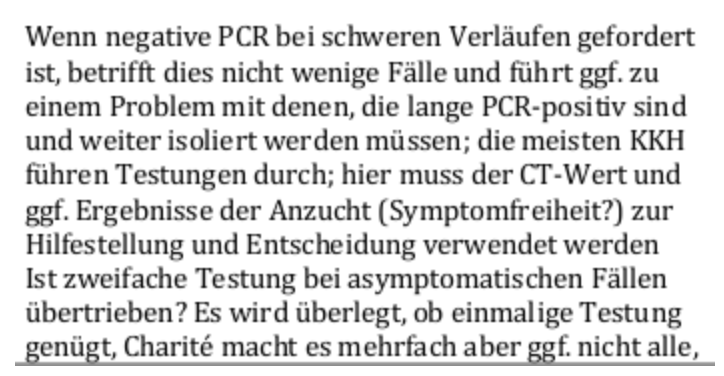

Auch die ggf. lange PCR-Positivität wurde am 19.06.2020 thematisiert, wobei das Zusammenspiel zwischen CT-Wert und Viruskultur erwähnt wurde.

Äußerst willkürlich und unserer Ansicht nach unangemessen risikobetont lief wenige Tage zuvor die Festlegung des CT-Grenzwertes für eine “gültige” Infektion ab. Nach 7 Tagen ab Symptombeginn und CT-Werten über 25 war fast keine Viruskultur mehr positiv. Wegen einer Ausnahme, die mit CT-Wert 29 noch kulturpositiv war, wurde der Grenzwert mit 30 festgelegt.

Was wusste das RKI? – Spezifität und falsch-positive Ergebnisse

Auch das unangemessen hohe Aufkommen an falsch-positiven Ergebnissen und damit verbundener Haft-ähnlicher Isolation/Quarantäne für mutmaßlich mehrere 100.000 Menschen ohne jeglichen Zweck haben wir in einer Aussendung kritisiert. [5]

Auch diese Problematik war dem RKI bewusst. Nicht nur das, es wurden wiederum am 19.06.2020 himmelschreiend schlechte Zahlen schulterzuckend zur Kenntnis genommen. 98% Spezifität (d.h. wie oft meldet der Test fälschlicherweise ein Signal in 100 tatsächlich negativen Proben) ist schon unerwartet schwach. Ein Test mit nur 92% Spezifität sollte gar nicht angewandt werden dürfen.

Anmerkung nebenbei: In diesen Protokollen kommen immer wieder Schlampigkeitsfehler vor. So auch in dieser Passage. Aus dem englischen möchte man specificity intuitiv durchaus mit Spezifizität übersetzen. Doch der korrekte Begriff im Deutschen ist tatsächlich Spezifität.

Was wusste das RKI? – Saisonalität

Auch dem Reproduktionsfaktor bzw. R-Wert als angeblich wichtigstem Parameter einer Epidemie haben wir in einer Aussendung den saisonalen Trigger gegenübergestellt. Dieser erklärt unseres Erachtens nach Zirkulation und wellenförmiges Auftreten von Krankheit/Symptomen bei respiratorischen Erregern deutlich besser. [6]

Wenngleich dieser Unterschied am RKI nicht direkt bekannt sein dürfte, so wurde doch recht früh am 06.05.2020 die Frage nach der Saisonalität aufgeworfen.

Schlussfolgerung

Sämtliche hier und in anderen Medien aufgezeigten Punkte waren freilich bereits 2020 bekannt. Kritiker der Corona-Maßnahmen haben diese Fragen von Anfang an aufgeworfen, wurden jedoch als Verschwörungstheoretiker, “Schwurbler”, Coronaleugner oder schlimmeres beschimpft und diskreditiert. Die narrativhörigen Experten und Leitmedien haben dies befeuert und nach anfänglich sachter Kritik keine Fragen mehr gestellt.

Nun liegt amtlich vor, dass diese Fragen auch von den Wissenschaftlern und Experten des deutschen Krisenstabs gestellt wurden. Warum manche Unklarheiten nicht weiterverfolgt bzw. manche Erkenntnisse nicht in die Tat umgesetzt wurden, lässt sich nur mit politischem Willen erklären.

Die Grünen für Grundrechte und Informationsfreiheit (GGI) gehen davon aus, dass es in Österreich nicht wesentlich anders zugegangen ist. Zwar kennen wir einerseits die groteske Tragödie namens GECKO, deren öffentlich zugängliche Berichte ein schockierendes Ausmaß an wissenschaftlicher Unbelesenheit und intellektueller Bequemlichkeit offenbart haben. [7] Andererseits werden wohl viele Diskussionen und Rechercheergebnisse unter Verschluss geblieben sein. Wir fordern volle Transparenz und weiterhin eine ehrliche Aufarbeitung der Corona-Jahre.

Quellenangaben

[1] Schreyer P. „Es soll hochskaliert werden“. Multipolar Magazin, 2024. online: https://multipolar-magazin.de/artikel/rki-protokolle-1

[2] Spiekermann B. Die brisanten Corona-Protokolle des RKI. Zweites Deutsches Fernsehen, 2024. online: https://www.zdf.de/nachrichten/politik/deutschland/rki-protokolle-corona-klagen-100.html

[3] Red. Mehr als tausend Passagen geschwärzt: Multipolar veröffentlicht freigeklagte RKI-Protokolle im Original. Multipolar Magazin, 2024. online: https://multipolar-magazin.de/artikel/rki-protokolle-2

[4] Anonym. Der PCR-Test – Goldstandard der Verwirrung. Grüner Verein für Grundrechte und Informationsfreiheit, 2023. online: https://ggi-initiative.at/wp/pm-23-der-pcr-test-goldstandard-der-verwirrung

[5] Anonym. Falsch positive Testungen: Eine vernachlässigte Größe mit enormen Auswirkungen. Grüner Verein für Grundrechte und Informationsfreiheit, 2024. online: https://ggi-initiative.at/wp/pm-99-falsch-positive-testungen-eine-vernachlaessigte-groesse-mit-enormen-auswirkungen

[6] Anonym. Der R-Wert – Kennzahl mit wenig Aussagekraft. Grüner Verein für Grundrechte und Informationsfreiheit, 2023. online: https://ggi-initiative.at/wp/pm-31-der-r-wert-kennzahl-mit-wenig-aussagekraft

[7] Anonym. GECKO – Sesselkreis im Operettenstaat. Grüner Verein für Grundrechte und Informationsfreiheit, 2023. online: https://ggi-initiative.at/wp/pm-50-gecko-sesselkreis-im-operettenstaat

Was tun bei einem Covid-Impfschaden? MWGFD präsentiert Leitfaden für Betroffene

Für den MWGFD hat der Arzt für Allgemeinmedizin und Naturheilverfahren Andreas Diemer einen Leitfaden für Menschen verfasst, die nach ihrem Covid-Schuss unter einem Impfschaden leiden. Neben möglichen Symptomen erörtert er dabei auch sinnvolle Laboruntersuchungen und Behandlungsmethoden mit positivem Nutzen-Risikoverhältnis.

Die Impfopferbroschüre „Was tun bei einem Covid-Impfschaden? Ein Leitfaden für Betroffene”, die unser MWGFD-Mitglied Andreas Diemer, Arzt für Allgemeinmedizin/Naturheilverfahren und Diplom-Physiker erstellt hat, bietet den durch die Covid-Impfstoffe geschädigten Menschen und deren Angehörigen einen umfassenden, wertvollen Überblick über wichtige „To Do’s”, die bei einem mutmaßlichen Impfschaden zur berücksichtigen sind. Ausgehend von der Beschreibung von Kriterien, die auf einen Impfschaden hindeuten können, und einer Auflistung von Symptomen, die eine Differenzierung von „Long Covid” und „Post-Vac” erlauben, beschreibt Andreas Diemer sinnvolle Laboruntersuchungen zur Verifizierung des „Post-Vac”-Verdachts.

Darüber hinaus bietet der Leitfaden konkrete Hilfe für Betroffene, indem allgemeine medikamentöse Behandlungsmethoden mit positivem Nutzen-Risikoverhältnis, die neben der spezifischen schulmedizinischen und naturheilkundlichen Behandlung in Frage kommen, sowie nichtmedikamentöse Methoden der Selbstbehandlung vorgestellt werden. Abgerundet wird die Broschüre durch juristische Tipps zu Versorgungsleistungen, Schmerzensgeld, Klagemöglichkeiten und künftigen Impfbefreiungen. Eine Liste mit wichtigen Adressen und Webseiten schließt den detaillierten Leitfaden ab. Wir hoffen, um mit den Worten des Autors Andreas Diemer zu sprechen, den durch die Covid-Impfung geschädigten Menschen „mit diesen Ausführungen eine kleine Hilfe” auf ihrem „Weg durch den Dschungel von Fachausdrücken, Vorschriften” gegeben zu haben, und wünschen all denen, die sich dieses Leitfadens bedienen werden, beste Genesung!

Ein Covid-Impfschaden kann sich schon sehr kurz nach der Injektion, aber auch erst Monate bis Jahre später bemerkbar machen. Um die Impfung als Ursache für einen Sterbefall oder eine Erkrankung eindeutig zu belegen, können Sie Gewebsproben, die aus den Organen eines geimpften Verstorbenen entnommen wurden, untersuchen lassen. Idealerweise sollte die Entnahme der Gewebsproben nach den von Prof. Arne Burkhardt ausgearbeiteten Kriterien erfolgen. Ein von ihm erstelltes Formular mit Hinweisen und Anregungen zur Obduktion von Verstorbenen können Sie hier auf der MWGFD-Webseite kostenlos downloaden und an den die Obduktion durchführenden Arzt weiterleiten.

Das von MWGFD e. V. neu gegründete Labor, das Institut für molekulare Diagnostik, arbeitet hierbei mit einem Team von Pathologen zusammen. Die Koordination der Untersuchungen erfolgt über die MWGFD-Meldestelle für mögliche Impfschäden/Impftodesfälle, an die Sie sich im Bedarfsfall wenden können.

Pressekonferenz des Vereins für Impfopfer – wir sprachen mit den anwesenden Experten

Der österreichische Verein für Impfopfer setzte am vergangenen Mittwoch ein starkes Zeichen im Sinne der durch die experimentellen Covid-19 Präparate geschädigten Menschen. Bei einer Pressekonferenz in Linz kamen ein Ganzheitsmediziner, ein Facharzt, ein Pathologe und ein Rechtsanwalt zu Wort. Ein besonders erschütternder Fall eines Betroffenen wurde von diesem selbst vorgetragen. In Österreich werden Impfopfer vom Staat weiterhin weitgehend ignoriert und im Stich gelassen.

Wo die Systemmedien wieder einmal fehlten, war Report24 selbstverständlich direkt vor Ort – Seite an Seite mit den Kollegen von AUF1, RTV, der Status, Kla-TV und mehr. Dabei wäre es sehr wichtig, wenn die Botschaft endlich in die Welt hinausginge: Hier wurden zahllose Menschen schwer geschädigt, sie benötigen nun Hilfe. Report24 hat sich mit den vor Ort vertretenen Experten unterhalten – sehen Sie diese Interviews auf Rumble.

Hinter dem Verein für Impfopfer steht unter anderem der weithin bekannte Megademo-Veranstalter Martin Rutter. Er kämpft nun darum, dass vom Staat alleine gelassene Impfopfer zu ihrem Recht kommen.

Report24 führte Gespräche mit den anwesenden Fachleuten:

Frau Mag. Britta Barnett, die den Verein für Impfopfer mitbegründet hat und durch die Veranstaltung führte.

Dr. Klaus Bielau, der Allgemeinmediziner der sich selbst am liebsten als Ganzheitsmediziner bezeichnet, erklärt dass die Impfung eine Vergiftung der Menschen ist – eine Schwächung der Lebenskraft. Man müsse den solchermaßen geschwächten Organismus dringend unterstützen.

Univ.-Doz. Dr. Hannes Strasser ist Facharzt für Urologie und Buchautor, der seit langem darum bemüht ist, die Ereignisse der Corona-Zeit aufzuarbeiten. Er erklärt, dass zunächst das Bewusstsein wichtig ist, dass Beschwerden seit der Impfung auch darauf zurückzuführen sein könnten. Dann müsse man sich einen Arzt suchen, der sich die Probleme genau ansieht und eine geeignete Therapie vorschlägt. Es sei sehr schwierig, weil die Infrastruktur und die Ambulanzen für dieses große Problem nicht vorhanden wäre.

Rechtsanwalt Dr. Gottfried Forsthuber schildert die rechtlichen Aspekte. Wie kann man vorgehen, wenn man geschädigt ist. Hat man eine Chance, wenn der Antrag auf Entschädigung abgewiesen wird? Einfach sei dies derzeit vor österreichischen Gerichten noch nicht. Die Behörden würden auch weiterhin alles zu tun, um Impfschäden zu negieren. Das Wichtigste, um zu seinem Recht zu kommen, sei eine lückenlose Dokumentation ab der ersten Minute. Es stellt sich immer die Frage: Wurde ordentlich aufgeklärt?

Primarius Dr. Helmut Luck erzählt, dass die Todesfälle im Impfjahr nicht deutlich zurückgingen sondern im Gegenteil auf hohem Niveau blieben. Er spricht mit Report24 über die gefürchtete Herzmuskelentzündung nach der Impfung. Dabei kann auch eine „milde Myokarditis“ zum Tod führen. Auch zehn Jahre nach einer Myokarditis ist die Chance, an einem Herzstillstand zu sterben, deutlich erhöht.

Der in Österreich tätige Verein für Impfopfer ist unter dieser Webadresse zu finden.

Deutsche Wirtschaft im „Geier Sturzflug“

Von MEINRAD MÜLLER | Michael Mross, der Mann, der die Wirtschaft besser kennt als seine eigene Westentasche, hat dazu eine klare Meinung. Wenn eine Kuh krank ist, weiß der Bauer, was zu tun ist: ab zum Tierarzt, vielleicht sogar zum Metzger, aber was macht man mit einer kranken Wirtschaft? Laut dem jüngsten Frühjahrsgutachten der Wirtschaftsinstitute […]

Wie weiter mit der Kernenergie? Klaus-Dieter Humpich zu Gast in der AfD-Fraktion im Bundestag

Der Referent Klaus-Dieter Humpich ist promovierte Ingenieur. Mit Schwerpunkt Kernenergie. Einen besseren Vortragenden zu finden dürfte jeder Partei schwerfallen. In seinem Vortrag mit anschließender Diskussion im Deutschen Bundestag am 19.3.24 (hochgeladen am 23.3.24) stellte er die vielen neuen sicheren Kernkraft-Generationen aus verschiedenen Ländern und von einigen Herstellern vor, zum Beispiel aktuelle Druck- und Siedewasser-Reaktoren.

Die Veranstaltung dauerte knapp 2 h. Wer möchte kann sich die hochinteressante Diskussion im Anschluss an den Vortrag hier ansehen.

Was uns entrissen wurde. “Meine Oma”

Ich konnte es nicht fassen. Ein Hospiz. Sterbende Menschen. Ein Einzelzimmer. Eine krebskranke Frau, dem Tode nahe. Kein oder kaum Kontakt zu dem Personal (welche sowieso volle Schutzmontur trugen). Von Felix.

Ich konnte es nicht fassen. Ein Hospiz. Sterbende Menschen. Ein Einzelzimmer. Eine krebskranke Frau, dem Tode nahe. Kein oder kaum Kontakt zu dem Personal (welche sowieso volle Schutzmontur trugen). Von Felix.

Der Beitrag Was uns entrissen wurde. “Meine Oma” erschien zuerst auf Philosophia Perennis.

Internationaler Gerichtshof verpflichtet Israel zu Maßnahmen gegen Hungersnot im Gazastreifen

Die Richter des Internationalen Gerichtshofs (IGH) haben Israel am Donnerstag einstimmig angewiesen, alle notwendigen und wirksamen Maßnahmen zu ergreifen, um die unverzügliche Versorgung der palästinensischen Bevölkerung im Gazastreifen mit Grundnahrungsmitteln sicherzustellen. Diese Anordnung wird erlassen, nachdem der IGH im Januar Israel des Völkermords schuldig befunden hatte und nachdem noch auch der UNO-Sicherheitsrat eine Waffenruhe verfügt […]

Der Beitrag Internationaler Gerichtshof verpflichtet Israel zu Maßnahmen gegen Hungersnot im Gazastreifen erschien zuerst unter tkp.at.

„Mühsam aufgebaut“: Ethikrat-Chefin Buyx ärgert sich über fehlende Dankbarkeit für Impfverbrechen

Im Zuge der Veröffentlichung der stark geschwärzten RKI-Protokolle stehen die deutschen Corona-Maßnahmen und die Evidenz der Impfungen wieder im Kreuzfeuer. In RKI-Sitzungen wurden etliche Positionen kritischer Wissenschaftler und Bürger bestätigt. Für die Ethikrat-Vorsitzende Alena Buyx sind jedoch vor allem „wilde, unseriöse und negative Fehl- und Überinterpretationen“. Im Interview mit dem Spiegel empört sie sich über die kritischen Sichtweisen all jener, die unter Maßnahmen und Impfzwang litten, und befindet, man müsse doch gerade die Impfung als „großartige Menschheitsleistung“ feiern.

Ein Kommentar von Vanessa Renner

Die RKI-Protokolle zeigen unter anderem auf, dass Wissenschaftler sehr wohl schon vor Beginn der Massenimpfkampagnen für die Allgemeinbevölkerung wussten, dass die Impfung Übertragungen nicht verhindert (so sei die Maskenpflicht daher auch für Impflinge „definitiv beizubehalten“). Im März 2021 konstatierte man dann ganz deutlich, dass Privilegien für Impflinge „fachlich nicht begründbar und nicht sinnvoll“ seien.

Dennoch redete die Politik der Bevölkerung ein, Impflinge seien vor Infektionen geschützt und dürften daher – anders als Ungeimpfte – vermehrt zur Normalität zurückkehren. Zwar scheiterte der Versuch einer gesetzlichen allgemeinen Impfpflicht, doch Personal im medizinischen Bereich wurde vielfach zur Impfung gezwungen: Ungeimpften drohte der Jobverlust. Das Maßnahmenregime erwies sich in etlichen Studien als nutzlos und schädlich. Dennoch möchte nun ausgerechnet die Vorsitzende des deutschen Ethikrats, Aleny Buyx, deren Aufgabe es gewesen wäre, von vornherein Abwägungen nach ethischen Aspekten zum Wohle der Bevölkerung anzustellen, den Menschen erzählen, dass sie gefälligst dankbarer sein sollten.

Gegenüber dem „Spiegel“ befindet sie, man solle doch „über Positives sprechen“ – etwa darüber, „dass diese Impfung eine großartige Menschheitsleistung ist! Dass sie die Pandemie beherrschbar gemacht, uns letztlich gerettet hat. In Dänemark, Neuseeland, Großbritannien waren sie so stolz auf ihre Impfkampagne, und entsprechend wurde darüber berichtet. Während medial bei uns teils hinten eingerissen wurde, was vorn mühsam aufgebaut worden war.“ Darüber habe sie sich manchmal geärgert, gibt sie an.

Die Behauptungen von Buyx sind nicht nur vielfach widerlegt worden, sie sind auch hochgradig bedenklich. Was wurde denn „mühsam aufgebaut“? Dass in die Entwicklung und Herstellung der Impfstoffe selbst keine große Mühe geflossen sein kann, zeigen schon die Hinweise auf DNA-Verunreinigungen in den Vakzinen deutlich. Was sonst wurde „aufgebaut“? Ein Konstrukt aus irreführenden bis falschen Behauptungen, um die Gesellschaft zu spalten, „Folgebereitschaft“ herzustellen und die Menschen zu etwas zu nötigen, was sie vielfach nicht wollten, was ihnen keinen bestätigten Nutzen brachte und was ihnen dafür schwere gesundheitliche Schädigungen bescheren konnte. Wenn es das ist, was man beim Ethikrat als Erfolg verkaufen möchte, dann verrät man offenkundig seinen eigenen Auftrag.

Buyx‘ Behauptungen, es habe in der sogenannten Pandemie viel mehr Positives als Negatives gegeben und Kritik sei überwiegend nur „rechtes Getöse“, ist entlarvend – insbesondere vor dem Hintergrund, dass eben diese Personalie bereits im nächsten Gremium installiert wurde, das zu neuen Gesundheitskrisen beraten soll.

COMPACT TV: RKI-Akten – ist DAS der General, der die Befehle gab?

Es ist bewiesen: Dank der RKI-Akten ist nun klar, dass sich Regierung und Robert-Koch-Institut bewusst gegen wissenschaftliche Erkenntnisse entschieden und dem deutschen Volk vorsätzlich Schaden zugefügt haben. Ein Fall für die Justiz. Doch wer gab am Ende die entscheidenden Befehle? Die Spuren führen ins Militär. Buchautor Manfred Kleine-Hartlage und COMPACT-Chef Jürgen Elsässer kommentieren die spannenden […]

Am 1. April enden die gratis Corona-Tests bei niedergelassenen Ärzten – doch die protestieren

Es scheint unfassbar: Am 30. Juni 2023 fielen (viel zu spät) die Corona-Maßnahmen – doch in Österreich wurden im niedergelassenen Bereich bis heute Corona-Tests im Verdachtsfall als Kassenleistung übernommen und von Steuergeldern finanziert. Ab 1. April soll damit nun endlich Schluss sein. Doch Ärzte kritisieren diesen Schritt. Sie konnten immerhin bis zu 25 Euro pro Test mit der Versicherung abrechnen! „Dass dieses lukrative Geschäftsmodell nun gefährdet ist, stößt sicher vielen sauer auf„, kommentiert MFG-OÖ-Klubobmann Manuel Krautgartner.

Presseaussendung der MFG:

Das Ende der gratis Corona-Tests im niedergelassenen Bereich – auch ein Ende von Steuergeldverschwendung?

Mit 1. April 2024 stehen die kostenlosen Corona-Tests im niedergelassenen Bereich vor dem Aus. Während dieser Umstand von Ärzten stark kritisiert wird, weist die MFG darauf hin, dass dies längst überfällig ist.

Obwohl am 30. Juni 2023 die Corona-P(l)andemie in Österreich für beendet erklärt wurde und damit die Maßnahmen fielen, wurden Corona-Tests im Verdachtsfall im niedergelassenen Bereich nach wie vor als Kassenleistung übernommen und vom Bund – also vom Steuerzahler – finanziert. Diese Regelung soll nun mit 1. April 2024 auslaufen. Laut Medienberichten wird dieser Umstand von Ärzten stark kritisiert. Johannes Steinhart, Präsident der Wiener und der Österreichischen Ärztekammer, fordert vom Bund ein „rasches Einlenken und eine langfristige Verlängerung der kostenlosen Tests in den Ordinationen“. Bisher konnten Ärzte laut Medienberichten bis zu 25 Euro (!) pro Test der Sozialversicherung verrechnen. „Dass dieses lukrative Geschäftsmodell nun gefährdet ist, stößt sicher vielen sauer auf“, so LAbg. Manuel Krautgartner, MFG-OÖ Klubobmann.

„Dass dieses lukrative Geschäftsmodell nun gefährdet ist, stößt sicher vielen sauer auf.“

LAbg. Manuel Krautgartner, MFG-OÖ Klubobmann

„Es hat wohl vier Jahre gedauert, dass die Regierung erkannt hat, dass es sich bei Corona um eine grippeähnliche Erkrankung ohne ein gesteigertes Gefährdungspotential handelt und keine sündteuren Testungen auf Steuerzahlerkosten erforderlich sind. Wir von der MFG haben von Anfang an kritisiert, dass durch Österreichs Test-Wahn die P(l)andemie sozusagen ,herbeigetestet‘ wurde“, so LAbg. Dagmar Häusler, BSc., MFG-Österreich Bundesparteiobmann Stv.

„Es hat wohl vier Jahre gedauert, dass die Regierung erkannt hat, dass es sich bei Corona um eine grippeähnliche Erkrankung ohne ein gesteigertes Gefährdungspotential handelt und keine sündteuren Testungen auf Steuerzahlerkosten erforderlich sind.“

LAbg. Dagmar Häusler, BSc., MFG-Österreich Bundesparteiobmann Stv.

Manuel Krautgarnter stellt weiters folgende Frage in den Raum: „Es wurden während der P(l)andemie um Abermillionen Euro Steuergeld Tests beschafft. Wo sind diese ganzen Tests eigentlich? Sind die vielleicht schon verfallen? Falls nicht und sie jetzt noch im Rahmen der kostenlosen Testungen im niedergelassenen Bereich verwendet werden, zahlt der Steuerzahler im Endeffekt doppelt – einmal für die Beschaffung und ein weiteres Mal für die Durchführung der Testung. Einen sorgsamen und sparsamen Umgang mit Steuergeld stelle ich mir anders vor.“ Am Rande sei noch erwähnt, dass unabhängig durchgeführte Laboranalysen ergeben haben, dass sowohl die Flüssigkeiten in den Antigentests als auch die Teststäbchen hoch toxische Substanzen enthalten. „Und dafür hat der Corona-Test-Weltmeister Österreich über 5 Milliarden Euro ausgegeben? Das nenne ich Steuergeldverschwendung vom Feinsten!“, zeigt sich Manuel Krautgartner erzürnt.

Lauterbachs Beteuerungen unglaubwürdig: War bei RKI-Schwärzungen bereits im Amt

In den letzten Tagen versuchte der amtierende deutsche Gesundheitsminister Karl Lauterbach (SPD) die Schuld an den geschwärzten RKI-Protokollen des Corona-Krisenstabes auf seinen Vorgänger, Jens Spahn (CDU) abzuwälzen. Eine Analyse des zeitlichen Ablaufs zeigt: Die Schwärzung kann nur während Lauterbachs Amtszeit angeordnet worden sein – und dann wurde, ebenso unter Lauterbach, zwei Jahre lang gemauert.

Karl Lauterbach äußerte sich jüngst in einem Interview mit Deutschlandfunk ausführlich dazu, wie wichtig ihm die Aufklärung hinsichtlich Fehlern zu Beginn der angeblichen „Pandemie“ wäre. Doch ihn träfe keine Schuld, er wäre ja noch nicht im Amt gewesen. Siehe: RKI-Protokolle: „War nicht im Amt“ Lauterbach will Spahn opfern, um eigene Haut zu retten.

Doch seine Beteuerungen, mit den Schwärzungen der Protokolle nichts zu tun zu haben, haben einen Haken. Die Anfrage nach Informationsfreiheitsgesetz und der darauffolgende jahrelange Rechtsstreit fallen allesamt in seine Amtszeit. Wäre er um Aufklärung bemüht gewesen, hätte er die Protokolle bereits 2021 ungeschwärzt herausgeben können.

Der zeitliche Ablauf:

5. Mai 2021 – Multipolar bringt einen Antrag nach IFG auf Freigabe der Protokolle ein.

8. Dezember 2021 – Karl Lauterbach wird Bundesgesundheitsminister im Kabinett Scholz. Er ist gegenüber dem RKI weisungsbefugt.

30. Dezember 2021 – Die Behörde lehnt den Antrag von Multipolar ab. Ein Schriftverkehr zwischen den Anwaltskanzleien begann.

Der Anwalt des Multipolar Magazins, Christoph Partsch, führte in einem Artikel vom 28. März aus, dass es auch keine weiteren vier Wochen dauern müsse, um die Schwärzungen zu prüfen und betroffene Personen um Erlaubnis zu bitten. Das wäre in Fällen, wo das öffentliche Interesse eindeutig überwiegt, überhaupt nicht notwendig.

Angesichts der abgeschlossenen Beratungen gibt es außer überwiegenden Persönlichkeitsrechten und vielleicht noch Betriebs- und Geschäftsgeheimnissen privater Dritter keine Ausnahmegründe mehr, die eine Schwärzung rechtfertigen.

Rechtsanwalt Christoph Partsch in Multipolar-Magazin

Multipolar weist weiters darauf hin, dass Karl Lauterbach in den letzten Tagen wohl mehrfach die Unwahrheit gesagt habe. So hätte dieser behauptet, das RKI habe während der Corona-Zeit unabhängig von politischer Weisung gearbeitet. Die bislang veröffentlichten Teile der RKI-Files belegen das gegenteil. Beispielsweise hat das Gesundheitsministerium am 29. 6. 2020 verfügt, dass die Risikoeinschätzung auf „hoch“ zu verbleiben hat. Der Umstand, dass die „neu übermitteltern Fälle aktuell rückläufig“ wären, sollte der Öffentlichkeit verheimlicht werden.

Long-Covid-Institut sperrt zu

Long Covid ist nicht mehr “in”: Weil die öffentlichen Gelder ausgelaufen sind, muss das Rostocker Institut für Long-Covid zusperren. Das Rostocker Long-Covid-Institut sperrt wieder zu. Nach nur eineinhalb Jahren Tätigkeit ist die Arbeit wieder erledigt, denn die Förderungen des Landes sind ausgelaufen und ohne öffentliche Zuwendung ist der Betrieb „nicht mehr wirtschaftlich“. Das hat die […]

Der Beitrag Long-Covid-Institut sperrt zu erschien zuerst unter tkp.at.