Kategorie: Nachrichten

Sie können für unseren Rechtsstreit mit der EU wegen den Sanktionen spenden

Seit die EU Alina Lipp und mich unter Sanktionen gestellt hat, gilt, dass uns niemand mehr irgendeinen wirtschaftlichen Vorteil zukommen lassen darf. Das ist nach EU-Recht als Umgehung der Sanktionen strafbar. Laut unserer Anwältin ist unser Recht auf juristischen Beistand davon aber nicht betroffen, was bedeutet, dass Sie der Anwältin zweckgebundene Spenden zukommen lassen können, […]

Großbritannien: Behörden reißen Nationalflaggen herunter – das steckt dahinter! – Exklusivinterview mit Andy Saxon

In diesem exklusiven Interview spricht Andy Saxon, der Gründer von „Operation Raise the Colours“, erstmals über die Ursachen und Ziele der patriotischen Bürgerbewegung.

Was als kleine Bürgerinitiative begann, hat sich inzwischen zu einer großbritannienweiten Aktion entwickelt: Menschen hängen den britischen Union Jack , die englische St.-Georges-Flag

, die englische St.-Georges-Flag und die walisische Flagge

und die walisische Flagge wieder in ihren Städten auf.

wieder in ihren Städten auf.

Saxon erklärt, warum die Rückkehr der Flaggen für viele britische Bürger ein Symbol für Patriotismus, Tradition und Identität ist, und weshalb die links-woke Labour-Regierung unter Premierminister Keir Starmer versucht, dieses Zeichen des patriotischen Widerstandes zu unterdrücken.

The post Großbritannien: Behörden reißen Nationalflaggen herunter – das steckt dahinter! – Exklusivinterview mit Andy Saxon appeared first on Deutschland-Kurier.

Kurzfristige Hitzewellen in Großbritannien werden vom Met Office instrumentalisiert, um mit 60-Sekunden-Hitzespitzen die Net-Zero-Phantasterei zu fördern

Chris Morrison, THE DAILY SCEPTIC

Die ständige Propagierung unnatürlicher 60-Sekunden-Hitzespitzen hat die Arbeit des britischen Wetteramtes während eines durchschnittlichen britischen Sommers geprägt, in welchem es auch zu ein paar kurzzeitigen Hitzewellen kam. Unterstützt von vermeintlich vertrauenswürdigen und unhinterfragten Botschaften in den Mainstream-Medien kann das von Net Zero besessene Met Office behaupten, dass die Tagestemperaturen auf Werte steigen werden, die in hochindustrialisierten Gebieten wie Flughäfen nur kurz berührt werden. Der 12. August war nur der jüngste Tag, an dem in Heathrow ein nationaler „Extremwert“ ausgerufen wurde. Während eines warmen Mai wurden in Heathrow acht der höchsten Tagestemperaturen gemessen. Diese Temperaturen stammen nicht nur von schlecht bewerteten Stationen, sondern die 60-Sekunden-Aufzeichnung ist auch eine Garantie dafür, dass jede unnatürliche Wärmespitze erfasst wird. Die Weltorganisation für Meteorologie empfiehlt, die von elektronischen Geräten erzeugten Temperaturen zwischen 1 und 10 Minuten zu mitteln, je nachdem, ob vorübergehende unnatürliche Temperatureffekte, oft als „Rauschen“ bezeichnet, entfernt oder minimiert werden sollen.

Das Met Office ist eindeutig ein großer Fan von Rauschen. Es ist zweifellos eine wichtige Triebfeder für die politische Botschaft von Net Zero und steht hinter zahlreichen Behauptungen, dass mehr heiße Tage als je zuvor aufgezeichnet werden. Dr. Eric Huxter hat wertvolle Arbeit zu Temperaturspitzen geleistet und beispielsweise gezeigt, dass es bei einminütigen Aufzeichnungen große Unterschiede im Vergleich zu den Messwerten zur vollen Stunde vor und nach dem Messzeitpunkt geben kann. Er stellte fest, dass der um 14.59 Uhr in Kew Gardens gemeldete nationale Mai-Rekord von 29,3 °C um 2,6 °C höher lag als der Wert um 14.00 Uhr und um 0,76 °C höher als der um 15.00 Uhr gemessene Wert.

Offensichtlicher Lärm, offensichtlicher Schrott. Huxter kommentiert: „In Anbetracht der Bestätigung, welche die Spitzen-Temperaturen dem Klimawandel-Narrativ geben, scheint es wenig Hoffnung auf eine wissenschaftliche Bewertung dessen zu geben, was das ‚wahre‘ meteorologische Signal tatsächlich ist.“ Wenig und nichts fasst es zusammen, und wenig hat gerade die Stadt verlassen. Das verschwörungsorientierte Met Office erklärte kürzlich, dass die Bemühungen einer kleinen Anzahl von Personen, „die Integrität der Met Office-Beobachtungen zu untergraben“, nicht weniger als „ein Versuch sei, die jahrzehntelange solide Wissenschaft über den weltweiten Klimawandel zu untergraben“.

Ein weiterer Vertreter der kleinen Schar von Leuten, die versuchen, jahrzehntelange solide wissenschaftliche Erkenntnisse zu untergraben, indem sie auf fehlerhafte Temperaturaufzeichnungen des Met Office verweisen, ist Ray Sanders. Im Zuge der Untersuchung aller mehr als 380 Temperaturstandorte des Met Office in UK untersuchte er kürzlich den Luftwaffen-Stützpunkt RAF Kenley, der zufällig auf halbem Weg zwischen Heathrow und Gatwick liegt. Er befindet sich in der Nähe von Caterham und Croydon, wird aber derzeit in Bereitschaft gehalten und hauptsächlich von Segelflugzeugen genutzt. Sanders stellt fest, dass er zwar der CIMO-Klasse 4 angehört und möglichen Temperaturfehlern unterliegt, aber eine Klasse 2 wäre, wenn er nur ein paar Meter von einer weitgehend ungenutzten Rollbahn entfernt wäre. Kein perfekter Standort, meint Sanders, aber offen genug, um künstliche Abschattung zu vermeiden.

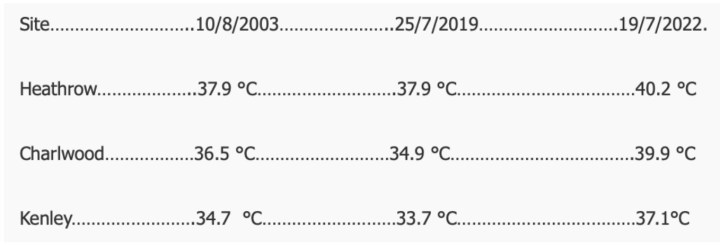

Natürlich kann sich niemand daran erinnern, dass Kenley die Bewerter beim Wettbewerb für „extreme“ Temperaturen beunruhigt hat. Unglaublich oder lächerlich, wie Sanders anmerkt, dass sowohl Charlwood (Gatwick) als auch Heathrow eine bessere Einstufung in Klasse 3 erhalten, was ihn dazu veranlasste, die höchsten Temperaturen der letzten drei nationalen Rekordtage zu vergleichen.

Solche Ungereimtheiten bedürfen einer Erklärung, obwohl das Wetteramt natürlich keine Chance hat, dies zu tun. Jüngste Anfragen von Sanders zur Informationsfreiheit wurden als „lästig“ und nicht im öffentlichen Interesse abgewiesen. Sanders fragt, ob das ländliche Caterham bis zu 4,2°C weniger als das ländliche Harmondsworth oder 2,8°C weniger als das ländliche Crawley verzeichnen würde. „Was kommt der ‚wirklichen‘ Temperatur wohl näher – ein offenes, weitgehend grasbewachsenes Gebiet oder ein Betondschungel, der von Zehntausenden von Autos und Hunderten von Düsenflugzeugen beherrscht wird?“ Und man könnte hinzufügen, warum sollten wir Behauptungen über einen Klima-Meilenstein wie am 19. Juli 2022 Glauben schenken, wenn die Messung auf halber Höhe des Hecks besagter Düsenflugzeuge erfolgt?

„Der Einsatz hochmoderner Instrumente in fast antiken Gehäusen in Gebieten, die zahlreichen verzerrenden Faktoren ausgesetzt sind, ist die absurde Unwirklichkeit, die das Met Office jetzt betreibt, nur um wild ungenaue Darstellungen der lokalen Bedingungen zu produzieren. Diese ganze Farce muss vollständig demontiert und von seriösen Meteorologen rekonstruiert werden“, schließt er.

Es gibt immer mehr wissenschaftliche Belege dafür, dass die Hitze in den Städten einen massiven Einfluss auf die weltweit deklarierten Temperaturen hat. Zwei türkische Meteorologen haben kürzlich Erkenntnisse aus der Untersuchung von Daten aus 10 Ländern veröffentlicht, aus denen hervorgeht, dass Flughäfen und Industriezentren im Durchschnitt 2,5°C bis 2,8°C wärmer sind als benachbarte ländliche Gebiete. Die Erwärmungstendenzen der letzten Jahrzehnte beschränken sich im Allgemeinen auf die städtischen Gebiete, heißt es in dem Bericht.

Der Net-Zero-Wahnsinn hat das Met Office in eine Zwickmühle gebracht. Eine Alternative zur Auflösung seines landesweiten Netzwerks wäre die Einsicht, dass das derzeitige Sammelsurium nicht geeignet ist, als Waffe zur Förderung der Net-Zero-Fantasie eingesetzt zu werden. Es ist, was es ist, nämlich ein grober Leitfaden für die lokalen Temperaturbedingungen an sehr kleinen spezifischen Orten. Auf Flughäfen wie Heathrow ist es ein nützliches Hilfsmittel für Hunderte von startenden und landenden Flugzeugen. Es ist kein geschätzter Leitfaden für das Klima-Armageddon.

Chris Morrison is the Daily Sceptic’s Environment Editor. Follow him on X.

Übersetzt von Christian Freuer für das EIKE

Der Beitrag Kurzfristige Hitzewellen in Großbritannien werden vom Met Office instrumentalisiert, um mit 60-Sekunden-Hitzespitzen die <em>Net-Zero</em>-Phantasterei zu fördern erschien zuerst auf EIKE – Europäisches Institut für Klima & Energie.

Ukraine attackiert Druschba-Pipeline – Mitteleuropas Ölversorgung lahmgelegt

Ungarn und die Slowakei haben ein Problem. Nach mehreren ukrainischen Angriffe auf die Druschba-Pipleline fließt nun für unbestimmte Zeit kein russisches Öl mehr. Kiew gefährdet die Energiesicherheit zweier EU- und NATO-Staaten – und das folgenlos. Keine Verurteilung aus den Brüsseler Hauptquartieren. Auch die deutschen Mainstreamer halten sich zurück. Es trifft ja ohnehin nur die “Schmuddelkinder”.

Die jüngste ukrainische Angriffswelle auf die Druschba-Pipeline zeigt, wie sehr sich der Krieg gegen Russland längst zu einem Krieg gegen Europas Energieadern entwickelt hat. Binnen weniger Tage wurden mehrere Pumpstationen der Leitung im russischen Grenzgebiet Bryansk mit Drohnen attackiert. In Flammen stand zuletzt die Anlage bei Unecha – ein Angriff, der die Ölversorgung von Ungarn und der Slowakei abrupt zum Stillstand brachte. Offiziell schweigt Kiew, doch Videos ukrainischer Drohneneinheiten im Netz lassen keinen Zweifel daran, wer hier die Finger am Abzug hatte.

Für Budapest und Bratislava ist das mehr als nur ein Nadelstich. Ungarn und die Slowakei gehören zu den wenigen EU-Staaten, die noch immer in großem Stil russisches Pipeline-Öl beziehen – legal, mit genehmigten Ausnahmen von den Brüsseler Sanktionen. Jetzt aber werden ihre lebenswichtigen Lieferungen sabotiert, und zwar nicht durch Moskau, sondern durch jene Ukraine, die seit Jahren mit EU-Geldern in dreistelliger Milliardenhöhe am Leben erhalten wird. Ungarns Außenminister Szijjártó brachte es auf den Punkt: “Mit diesen Angriffen schadet die Ukraine nicht Russland, sondern Ungarn und der Slowakei.”

Die Europäische Kommission reagiert wie so oft: gar nicht. Während die ungarische und slowakische Regierung in Brüssel Alarm schlagen, erklärt man in EU-Kreisen kühl, es bestehe “keine Gefahr für die Versorgungssicherheit”. Dass ganze Länder von heute auf morgen ohne ausreichend Nachschub dastehen, scheint dort keine Rolle zu spielen. Man hat sich so sehr in der transatlantischen Anti-Russland-Agenda eingerichtet, dass man bereit ist, die eigenen Mitgliedstaaten geopfert zu sehen. Selbst Washingtons Präsident Trump fand deutliche Worte und sprach von “Wut” über die Attacken, die seinen Partner Viktor Orbán unmittelbar treffen.

Ein Angriff auf die europäische Energiesicherheit

Die Druschba-Leitung ist das Symbol dieses Irrsinns: Jahrzehntelang floss Öl zuverlässig durch sie nach Mitteleuropa. Inzwischen ist sie Zielscheibe militärischer Angriffe, die offiziell gegen Russland gerichtet sein sollen, in Wirklichkeit aber die Abnehmer in Mitteleuropa treffen. Und es bleibt nicht bei Druschba. Bereits vor Monaten meldete Moskau vereitelte ukrainische Drohnenattacken auf die TurkStream-Gasleitung am Schwarzen Meer. Hätten diese ihr Ziel getroffen, wären Bulgarien, Serbien und Ungarn in ein energiepolitisches Chaos gestürzt worden. Gemeinsam mit Nord Stream, das 2022 in den Fluten der Ostsee gesprengt wurde, ergibt sich ein klares Muster: Jeder verbliebene russische Energiekorridor nach Europa wird ausgeschaltet.

Die Folgen sind absehbar. Russland an verliert Einnahmen, die EU verliert an Energiesicherheit – und die USA gewinnen an Einfluss, indem sie ihr teures Flüssiggas als Ersatz verkaufen. Doch während Washington profitiert, wächst in Mitteleuropa die Unruhe. Immer offensichtlicher wird, dass Kiew nicht nur gegen Russland Krieg führt, sondern auch die Energieversorgung seiner eigenen Sponsoren attackiert. Eine groteske Konstellation: Europa bezahlt die Ukraine, und die Ukraine zerstört die Infrastruktur, die Europas Wirtschaft mit am Leben erhält.

Und die Mainstreammedien? Die berichten zwar über die Angriffe und die potentiellen Folgen – nicht nur für Ungarn und die Slowakei, sondern auch für Deutschland – aber das wars dann auch schon. Die Tagesschau titelt beispielsweise lapidar “Ukraine beschießt Ölpipeline in Westrussland” – und in China ist ein Sack Reis umgefallen. Ganz nach dem Motto “Wir haben ja darüber berichtet”. Dass es hierbei um einen Angriff auf die Energiesicherheit von Millionen von Menschen in den beiden mitteleuropäischen Ländern geht? Nebensächlich. Es sind ohnehin nur die EU-Schmuddelkinder hauptsächlich davon betroffen.

Doch für die Brüsseler Eurokraten wären wirtschaftliche Probleme dort von Vorteil. Stark steigende Energiepreise könnten die Regierungen von Viktor Orbán und Robert Fico unter Druck setzen. Auch wenn man das nicht öffentlich zugeben würde, passen diese Angriffe ins Regime-Change-Konzept. Dass darunter unzählige Menschen leiden, spielt dabei keine Rolle – Hauptsache, man kann die politischen Ziele erreichen und “genehmere” Kandidaten an die Macht bringen.

Russlands Plasmaantrieb: Mit Atomkraft in 30 Tagen zum Mars?

Während der Westen Milliarden in woke Genderprojekte, “Diversity-Offices” und grünideologische Hirngespinste versenkt, bauen die Russen an der Zukunft der Raumfahrt. Von westlichen Medien wenig beachtet, hat Rosatom einen Prototypen für einen Plasmaantrieb vorgestellt. Damit könnten Expeditionen zum Mars Wirklichkeit werden.

Das Konzept klingt fast zu schön, um wahr zu sein. Ein magnetischer Plasmaantrieb, der mit gerade einmal 6 Newton Schub arbeitet, könnte der Weltraumantrieb der Zukunft sein. Doch der Teufel steckt im Detail: Es geht nicht um kurzzeitige brachiale Kraft wie bei herkömmlichen Raketen, sondern um beständige, hocheffiziente Beschleunigung. Statt auf einen kurzen Kraftstoß setzt der Antrieb auf konstante Beschleunigung: Mit über 100 Kilometern pro Sekunde Ausströmgeschwindigkeit schiebt der Plasmaimpuls das Raumschiff Woche für Woche schneller durchs All. Damit sinkt die Reisezeit zum Mars von knapp einem Jahr auf gerade einmal 30 bis 60 Tage. Für die Astronauten, die auf langen Flügen der kosmischen Strahlung ausgeliefert sind und auch für die Kosten und Logistik der interplanetaren Expansion ist dies ein gewaltiger Unterschied.

Während also westliche Raumfahrtbehörden kaum über die nächste Mars-Simulation in der Wüste von Utah hinauskommen, entsteht in Russland ein System, das tatsächlich in der Lage wäre, die Menschheit interplanetar zu machen. Natürlich nicht ohne atomaren Unterbau. Denn ein solcher Plasmaantrieb frisst Strom, und zwar in Größenordnungen von Hunderten Kilowatt bis hin zu Megawatt. Chemische Batterien? Völlig unbrauchbar. Solarenergie? Allenfalls für Kleinspielzeug im erdnahen Orbit. Die Russen setzen folgerichtig auf ihre Kernkompetenz: Atomreaktoren.

Genau hier zeigt sich die Doppelmoral. Wenn Russland einen nuklearen “Raumschlepper” plant, wird sofort das Schreckgespenst von radioaktiven Trümmern im Orbit an die Wand gemalt. Wenn jedoch westliche Institute wie Ad Astra Rocket Company oder die NASA von VASIMR-Antrieben träumen, die exakt dasselbe Prinzip verfolgen, applaudiert die Presse. Nur mit dem kleinen Unterschied: Während die Russen einen Prototyp in einer 14-Meter-Vakuumkammer laufen lassen, bleibt es bei den Amerikanern seit Jahrzehnten weitgehend bei Studien und PowerPoint-Folien.

Natürlich darf man nicht blauäugig sein. Der Weg vom Prototypen bis zur Einsatzfähigkeit im All ist weit. Materialermüdung durch das aggressive Plasma, die Frage der Kühlung, der Start eines funktionsfähigen Reaktors ins All – all das sind gewaltige technische Hürden. Aber der entscheidende Punkt ist: Russland ist bereit, diesen Weg zu gehen. Während der Westen seine Weltraumagenturen zunehmend in Soziallabore für Identitätspolitik umwandelt, wird im Osten echte Ingenieurskunst betrieben.

Sollte es Rosatom gelingen, das sogenannte “Flugmodell” bis 2030 zu realisieren, könnte sich die geopolitische Rangordnung im All radikal verschieben. Ein Plasmaantrieb mit atomarer Energieversorgung würde nicht nur bemannte Marsmissionen revolutionieren, sondern auch zur strategischen Waffe werden: Wer schnelle interplanetare Schlepper hat, kontrolliert Satelliten, Rohstofftransporte von Asteroiden und im Zweifel sogar militärische Operationen im All. In dieser Hinsicht ist das Projekt weit mehr als nur ein romantisches Versprechen für Weltraumfans – es ist ein geopolitischer Gamechanger.

Die Ironie ist kaum zu übersehen: Während westliche Narrative Russland gerne als rückständig und technikfeindlich darstellen, sind es genau die Russen, die dort Fortschritte machen, wo die Menschheit tatsächlich einen Sprung nach vorn braucht. Der Westen redet von Klimaneutralität und bastelt an windabhängigen Stromnetzen, die nicht einmal die eigenen Haushalte zuverlässig versorgen. Russland hingegen baut an Antrieben, die uns in wenigen Jahrzehnten durch das Sonnensystem tragen könnten.

Am Ende bleibt die Frage: Wer bringt die Menschheit wirklich voran? Jene, die Milliarden in Subventionen für E-Autos mit 200 Kilometer Reichweite pumpen, oder jene, die ernsthaft daran arbeiten, die Reisezeit zum Mars um 90 Prozent zu reduzieren? Die Antwort gibt sich von selbst – auch wenn sie im westlichen Mainstream wohl nie offen ausgesprochen werden wird.

EXKLUSIV-Interview: Mut-Unternehmer lässt AfD-Fahnen auf Bahnhof wehen!

Der Landwirt und Bahnhofs-Besitzer Poppe Gerken gestattete der AfD, auf seinem Bahnhof in der mecklenburgischen Kleinstadt Bützow (Landkreis Rostock) die Fahnen der Partei zu hissen!

Alltparteien und Mainstream-Medien sind außer sich vor Wut!

Der Deutschland-KURIER hat EXKLUSIV mit dem mutigen Unternehmer und Patrioten gesprochen!

hat EXKLUSIV mit dem mutigen Unternehmer und Patrioten gesprochen!

The post EXKLUSIV-Interview: Mut-Unternehmer lässt AfD-Fahnen auf Bahnhof wehen! appeared first on Deutschland-Kurier.

Neues Gerücht aus der Berliner Kungel-Küche: Will die SPD ihre Parteilinke Katarina Barley nach Karlsruhe schicken?

SPD-Fraktionschef Matthias Miersch wollte keine Namen nennen, als er am Donnerstag verkündete, seine Partei habe bereits eine neue Kandidat für das Amt einer Bundesverfassungsrichterin.

Jetzt scheint ein heißes Gerücht den Schleier der Hinterzimmerkungelei zu lüften: Die ehemalige Bundesjustizministerin und derzeitige Vizepräsidentin des EU-Parlaments Katarina Barley ist als Ersatz für Frauke Brosius-Gersdorf im Gespräch, die als juristische Linksaktivistin am Widerstand etlicher Unionsabgeordneter gescheitert war.

Was die extreme politische Positionierung angeht, passt zwischen Katarina Barley und Frauke Brosius-Gersdorff kaum ein Blatt Papier. Sie setzt sich vehement für völlige Liberalisierung der Abtreibung ein und unterzeichnete im EU-Parlament 2024 eine Resolution, die ein „Recht auf Abtreibung“ in der EU-Grundrechte-Charta festschreiben will.

Auf dem SPD-Parteitag Ende Juni plädierte Barley zudem offen für ein AfD-Verbotsverfahren: Man müsse das „sorgfältig prüfen“ und dann „die nötigen Schritte einleiten“.

Eine Kandidatur Barleys klingt plausibel; die SPD hatte die 56jährige Deutsch-Britin schon im Juli ins Gespräch gebracht, um die Union zusätzlich unter Druck zu setzen. In Trier hat die promovierte Juristin schon einmal als Richterin gearbeitet, in Karlsruhe war Barley Ende der Neunziger als wissenschaftliche Mitarbeiterin am Bundesverfassungsgericht tätig.

Eine Bestätigung der Personalie steht zwar noch aus, „Bild“ zitiert aber Stimmen aus der Unionsspitze, Barley sei „ganz sicher bei der Union mehrheitsfähig“. Offiziell übt sich die SPD allerdings auch gegenüber dem Koalitionspartner noch in Geheimniskrämerei.

AfD-Parteivize Stephan Brandner spricht in einer ersten Reaktion von einem „weiteren verrückten SPD-Vorschlag“ zur Besetzung des Bundesverfassungsgericht. Für die SPD sei es offenbar schon Qualifikation genug, ausgewiesene AfD-Hasserin zu sein, erklärt Brandner: „Dass es schon längst nicht mehr um die einfache Besetzung vakanter Richterstellen, sondern um die gezielte Politisierung des höchsten deutschen Gerichts geht, dürfte nun für jeden offensichtlich sein und ist eine Schande für unsere Demokratie und die Gewaltenteilung.“

The post Neues Gerücht aus der Berliner Kungel-Küche: Will die SPD ihre Parteilinke Katarina Barley nach Karlsruhe schicken? appeared first on Deutschland-Kurier.

Deutsches Gesundheitsministerium verteidigt neues WHO-Gesetz

Das deutsche WHO-Gesetz wird aktualisiert und sieht umfassende Eingriffe in die Grundrechte vor. Das deutsche Gesundheitsministerium freut sich darauf, will man sich doch so auf die nächste Pandemie vorbereiten. TKP hat Mitte August berichtet: Deutschland überarbeitet seine Gesetzeslage im Sinne der WHO. Dort wurden die Internationalen Gesundheitsvorschriften (IGV) geändert, diese sind in einigen Wochen rechtswirksam. […]

Der Beitrag Deutsches Gesundheitsministerium verteidigt neues WHO-Gesetz erschien zuerst unter tkp.at.

Zollabkommen: EU-Kapitulation vor Trump

Am Donnerstag haben Washington und Brüssel ihr Handelsabkommen vorgestellt. Für die EU wird es teuer, die Kommission hat vor den USA kapituliert. Man hat die Rolle als amerikanisches Protektorat einzementiert. Trump hat die EU auf ihren Platz verwiesen. Es ist ein Sieg auf allen Ebenen für Donald Trump, der vor einigen Wochen noch als große […]

Der Beitrag Zollabkommen: EU-Kapitulation vor Trump erschien zuerst unter tkp.at.

“Wie der Westen die Diplomatie kriminalisierte”

Klimapropheten blamiert: Der angeblich „heißeste“ Sommer 2025 fiel ins Wasser

Der Sommer 2025 sollte laut Prognosen der Meteorologen als „heißester aller Zeiten“ in die Geschichte eingehen. Schlagzeilen wie „Deutschland droht der Klimakollaps“ dominierten die Medien, während Wetter-„Experten“ und „Klimaforscher“ vor Rekordtemperaturen, Dürre und Waldbrandgefahr warnten. Doch wieder einmal lagen Meteorologen, Medien und Klima-Panikmacher daneben – und die Realität schrieb ein völlig anderes Wetterkapitel.

Von Guido Grandt

Nachfolgend einige exemplarische Klima-Katastrophen-Schlagzeilen, die gezielt zur Umprogrammierung der öffentlichen Wahrnehmung beitragen sollten (Hervorhebungen durch mich) – und zugleich das eklatante Versagen der selbsternannten „Wetter- und Klimaforschungs-Experten“ offenlegen:

- Die Hessische/Niedersächsische Allgemeine (HNA) prophezeite den Apokalypse-Klima-Wahn schon am 3. April 2025 mit folgender Schlagzeile: „Wetterexperte warnt vor ‚Höllensommer 2025‘ – Extrem-Szenario kündigt sich jetzt schon an.“

- ProSieben verkündete am 13. Mai 2025: „Warnung: Steht uns ein historischer Dürre-Sommer bevor? – Die Wettermodelle schlagen Alarm: Deutschland könnte im Sommer 2025 ein Hitzeszenario besonderen Ausmaßes bevorstehen.“

- Die BILD hielt am 14. Mai 2025 fest: „Wetterexperten warnen vor Hitze und Dürre: Kommt jetzt der Jahrhundert-Sommer? – Meteorologe Dr. Karsten Brandt (…)‚Es kann ein sehr warmer Sommer werden, mit Temperaturen von 30 bis 35 Grad und mit entsprechend wenig Niederschlag, sogar einer lang anhaltenden Dürre. Die Wahrscheinlichkeit, dass dies so eintrifft, kann bei 60 bis 65 Prozent liegen.‘“

- t-online legte am 15. Mai 2025 nach: „Dieser Sommer droht alle Rekorde zu sprengen – Der Frühling 2025 ist ungewöhnlich trocken – und Meteorologen warnen: Wenn sich das Wettermuster fortsetzt, erwartet Deutschland ein Jahrhundertsommer. Die Anzeichen verdichten sich: Ein heißer, womöglich gefährlicher Sommer könnte bereits seinen Anlauf genommen haben – unsichtbar, still und unaufhaltsam. Regen bleibt aus und die Temperaturen liegen teils fünf bis zehn Grad über dem Schnitt. Der Meteorologe Dominik Jung ist alarmiert (…)“

- Einen Tag später, am 16. Mai 2025, blies die Frankfurter Rundschau in dasselbe Katastrophen-Horn: „Europäisches Wettermodell zeigt klare Tendenz: Deutschland droht 2025 ein ‚Höllensommer‘ – Laut den neuesten Langfristprognosen des renommierten europäischen Wetterzentrums ECMWF steht uns ein außergewöhnlich heißer und trockener Sommer bevor (…) Laut den aktuellen Modellrechnungen des ECMWF, auf die sich auch wetter.net bezieht, zeigt sich für die Sommermonate Juni, Juli und August beim Wetter eine klare Tendenz: Überdurchschnittlich hohe Temperaturen und anhaltender Hochdruckeinfluss, der kaum Platz für Regen oder kühlere Atlantikluft lässt.“

- dasWetter.com machte am 10. Juni 2025 folgendermaßen „Klima-Angst“: „Extrem-Sommer 2025 startet brutal: Blitzhitze, Großhagel und Unwetter rollen über Deutschland. – Deutschland erlebt eine abrupte Wettereskalation (…) Der Juni zeigt bereits, wohin die Reise geht: Ein Sommer der Extreme, kein Sommer der Erholung. Die Mischung aus kurzer Hitze, drückender Schwüle und explosiven Unwettern macht 2025 zu einem Ausnahmejahr. Von Blitzhitze bis Hagelhölle ist alles drin (…)“

- Focus Online am 12. Juni 2025: „Alle Wettermodelle einig: Sommer in Deutschland wird extrem heiß – Mit einer Wahrscheinlichkeit von 70 bis 100% wird der Sommer 2025 einer der heißesten im Vergleich zur Referenzperiode 1993 bis 2016. Sommer 2025: Alle Modelle zeigen extreme Hitze (…) Es ist also sehr wahrscheinlich, dass uns nicht nur ein extrem heißer, sondern auch ein trockener Sommer 2025 bevorsteht. Und auch die Prognosen für die nächsten Wochen sehen alles andere als gut aus. Es droht ein Hitze- und Dürrejahr (…)“

- Telepolis am 26. Juni 2025: „Droht Deutschland der heißeste Sommer aller Zeiten? – Schon der Juni bricht Temperaturrekorde. Meteorologen sind alarmiert: Der Sommer 2025 könnte alle Hitzerekorde sprengen (…) Klimaforscher schlagen Alarm: 40 bis 45 Grad bald normal? (…) Die Entwicklung folge vielmehr einem besorgniserregenden Muster, vor dem Klimaforscher seit Jahren warnen: ‚Hitzespitzen setzen früher ein, dauern länger an und erreichen neue Extremwerte.`“

- Die GRÜNEN reihten sich am 1. Juli 2025 auf ihrer Homepage mit ihrem politisierten Klima-Apokalypse-Wahn in die mediale Katastrophenberichterstattung ein: „Hitzewelle 2025: Was ihr wissen müsst (…) Deutschland erlebt eine Hitzewelle und eine schwere Dürre – es ist so trocken wie seit fast 100 Jahren nicht mehr. Egal ob für die Landwirtschaft, Industrie oder einfach als Trinkwasser: Das Wasser wird knapp. Große Flüsse wie der Rhein, die Elbe und die Donau führen Niedrigwasser, die Lebensmittelpreise steigen und in vielen Landkreisen wird der Wasserverbrauch eingeschränkt.“

- Der Karlsruhe-Insider vom 2. Juli 2025: „Experten decken auf: Sommer 2025 wird der heißeste aller Zeiten – Wetterexperten haben es schon länger vermutet: Der Sommer 2025 wird der heißeste aller Zeiten. Und nun könnte genau das tatsächlich eintreten. Die Menschen sollten sich gut vorbereiten. Alarm: Dieser Sommer wird extrem heiß (…)“

- Und noch einmal die Hessische/Niedersächsische Allgemeine (HNA) am 3. Juli 2025: „Deutschland-Wetter reißt historische Rekorde – 2025 droht der heißeste Sommer aller Zeiten. Langfristige Wettermodelle prognostizieren ebenfalls überdurchschnittlich warme Monate Juli und August. Ein echter Jahrhundert-Sommer ist nicht mehr ausgeschlossen.“

Statt „Hitze-Hölle“ Dauerregen

Die Realität sah gänzlich anders aus als vorhergesagt: kein „Hitzeflirren“, keine „Dürre“, kein „Kollaps der Landwirtschaft“. Nichts davon trat ein. Vor allem die Behauptung von „ausbleibendem“ oder „zu geringem“ Niederschlag erwies sich als haltlos – vielerorts fiel sogar deutlich mehr Regen als im langjährigen Durchschnitt.

So betrug laut Statista beispielsweise der durchschnittliche Niederschlag im Juli 2025 hierzulande 114 Liter pro Quadratmeter. Das vierteljährliche „Mittel“, wie es heißt, lag jedoch bei nur 78 Litern pro Quadratmeter! Das ergab einen Überschuss von 47 %.

Auch im Vergleich mit der aktuelleren und feuchteren Referenzperiode 1991 bis 2020 wurde das Soll um mehr als 30 % überschritten. Im Norden und Nordosten Deutschlands fielen verbreitet sogar 100 bis 150 und örtlich sogar 200 Liter pro Quadratmeter.

Statt Hitze-Hölle gab es starke Gewitter mit Dauer- und Starkregen bis hin zu Sturmwarnungen. Der Juli galt sogar als „zu nass“.

Statt Gluthitze „Affenkälte“

Und auch die vorhergesagte Gluthitze von 30 oder 40 Grad °C betrug im Juli durchschnittlich nur 18,4 °C!

Besonders kalt war es am 10. Juli in Meßstetten (Baden-Württemberg) mit gerade mal 3,5 °C, was dem bundesweiten Tiefstwert entsprach.

Zum Monatsende hin sorgte eine nordwestliche Anströmung für wenig sommerliche Gefühle im Land. Jacke, statt Badehose war angesagt.

Gummistiefel statt Strandschlappen – Regenschirm statt Sonnencreme

Im Juli gab es nur 189 Sonnenstunden und damit etwa 10 % weniger als in der Periode 1961 bis 1990 (211 Stunden). Noch deutlicher fiel das Defizit im Vergleich mit der jüngeren Referenzperiode 1991 bis 2020 aus. Diesbezüglich fehlte ein Sechstel auf den Referenzwert (226 Stunden). Der letzte Juli, in dem es noch weniger Sonne gab, datiert mit 166 Stunden aus dem Jahr 2011.

Schon im Mai 2025 bezeichnete der Wetterexperte Jörg Kachelmann die Behauptung, 2025 stehe ein „Höllensommer“ bevor, als „freie Erfindung, die in den Online-Medien sehr gut klickt“. Er hat recht behalten.

„Klima-Panik-Mainstream“ wehrt sich halbherzig

In Bezug auf die falschen Prognosen zu angeblich extremer Hitze, Regen- und Wasserknappheit im Sommer 2025 bemüht sich der Klima-Panik-Mainstream nun um jede erdenkliche Ausrede – statt die eigenen Fehlprognosen einzugestehen.

So heißt es beispielsweise in der Mitteldeutschen Zeitung am 6. August 2025: „Die Temperaturen lagen trotzdem höher als vor einem Jahrhundert. Allerdings: Das, was wir beim Blick aus dem Fenster sehen, ist Wetter. Was sich in langfristigen Datenreihen niederschlägt, ist Klima. Und da kann dieser Sommer, leider, keine Entwarnung geben. Trotz fehlender Sonne und viel Regen lag die Temperatur höher als zu Beginn der Aufzeichnungen.“

Alles klar?

Einige wenige Wetter-„Experten“ gaben den Irrtum zu, dass der Juli 2025 ungemütlich nass und damit völlig anders als vorhergesagt war. Wie etwa „The Weather Channel“-Meteorologe Jan Schenk: „Das war ‘ne richtige Fehlprognose, kann man sagen, aber man lernt ja draus.“

Propaganda statt Prognose

Kritiker werfen den Meteorologen und Klimaexperten längst vor, weniger wissenschaftlich als politisch zu agieren. Tatsächlich ist die systematische Dramatisierung des Wetters Teil einer medial-politischen Agenda, die vor allem Angst erzeugen soll – mit dem Ziel, klimapolitische Maßnahmen durchzusetzen.

Doch die Realität entlarvt die Panikmache als Farce. Allerdings bleibt bis heute eine breite Debatte über die systematischen Falschprognosen aus.

Panikmache als Geschäftsmodell

Die Frage drängt sich auf: Handelt es sich bei diesen dramatischen Prognosen um wissenschaftlich fundierte Vorhersagen – oder um ein Geschäftsmodell der Angst?

Kritiker warnen seit Jahren davor, saisonale Vorhersagen als „quasi sichere“ Zukunftsszenarien zu verkaufen. Denn wer über Monate im Voraus behauptet, genaues Wetter zu kennen, betreibt keine Meteorologie, sondern Märchenstunde.

Aber leider lässt sich mit Klimapanik immer noch gutes Geld verdienen. Zudem dient die ständige Übertreibung von Wetterextremen nicht etwa der Aufklärung, sondern der Erziehung der Bürger und damit dem politischen Klima-Aktivismus im rot-grünen Tarnanzug.

Politisch motivierte Wetterangst

Dass Wetter heute politisch ist, ist kein Geheimnis mehr. „Hitzesommer“, „Dürrekatastrophe“ oder „Rekordklima“ sind Begriffe, die inzwischen inflationär gebraucht werden – selbst wenn objektive Messwerte das Gegenteil zeigen.

Kritiker bemängeln eine gefährliche Entwicklung: Statt nüchtern zu informieren, bedienen viele Wetterdienste, Medien und Politiker eine Katastrophen-Erzählung, die zu Klima-Hysterie statt zu sachlicher Debatte führt.

Der Mechanismus der Klima-Angstindustrie

- Frühzeitige Panikwarnung: Schon Monate vorher werden Medien mit extremen Szenarien gefüttert.

- Politische Agenda: Die Warnungen werden mit klimapolitischen Forderungen verknüpft – CO₂-Steuer, Heizungsverbote, Fahrverbote.

- Kommerzialisierung der Angst: Klicks, Spendengelder, politische Aufmerksamkeit – und neue Fördergelder für Klimaforschung.

- Kaum Korrektur: Wenn die Prognosen scheitern, bleiben Schlagzeilen und Angstbilder im Gedächtnis. Eine große Richtigstellung? Fehlanzeige.

- Gefühl versus Fakten: Mediale Schlagzeilen wie „Hitze-Hölle“ oder „Klimakollaps“ ziehen Aufmerksamkeit. Doch wenn Realität (etwa: ein zu nasser, aber statistisch warmer Juli) gegen die Erwartung läuft, bleibt oft ein Glaubwürdigkeitsverlust – bei Wetterdiensten ebenso wie bei Medien.

Prognosen sind keine Fakten

Der verregnete Sommer 2025 entlarvt ein strukturelles Problem: die vorschnelle Dramatisierung langfristiger Wettertrends durch Medien, Meteorologen und Klimaaktivisten.

Wetter ist kein Wunschkonzert – und auch kein Werkzeug für politische Erziehungsmaßnahmen. Was bleibt: Weniger Hysterie, weniger Panik und mehr seriöse Wissenschaft.

Und:

- Ein Imageverlust für Meteorologie, wenn Vorhersagen so danebenliegen.

- Ein Glaubwürdigkeitsproblem für Medien, die Panik statt Information liefern.

- Ein politisches Risiko, wenn Klimapolitik auf überzogenen Katastrophenszenarien fußt.

Fazit: Mehr Wissenschaft – weniger Hysterie

Der Sommer 2025 verdeutlicht, wie riskant die Vermischung von Wettervorhersagen, politischer Agenda und medialem Alarmismus ist.

Wetter bleibt unberechenbar, langfristige Prognosen sind stets unsicher – und sollten auch als solche kenntlich gemacht werden.

Wer das Wetter jedoch für politische Zwecke instrumentalisiert, zerstört nicht nur die Glaubwürdigkeit seriöser Klimaforschung, sondern untergräbt auch dauerhaft das Vertrauen der Bevölkerung.

Guido Grandt (geb. 1963) ist investigativer Journalist, Publizist, TV-Redakteur und freier Produzent. Seine Arbeitsschwerpunkte liegen auf Recherchen zu organisierter Kriminalität, Geheimgesellschaften sowie auf brisanten Themen aus Politik, Wirtschaft, Finanzen, Militär und Sicherheit. Darüber hinaus widmet er sich der Aufdeckung verborgener oder tabuisierter Hintergründe zeitgeschichtlicher Ereignisse. Guido Grandt veröffentlichte bisher über 40 Sachbücher und verfasste rund 6.000 Artikel.

- Sein kostenloser Blog: https://www.guidograndt.de/;

- Seine Bücher: Guido Grandt bei Amazon

Quellen:

- https://www.hna.de/welt/warnt-vor-hoellensommer-2025-extrem-szenario-kuendigt-sich-jetzt-schon-an-wetterexperte-zr-93653376.html

- https://weather.com/de-DE/wetter/deutschland/news/2025-06-12-sommer-2025-alle-wettermodelle-zeigen-gluthitze

- https://www.telepolis.de/features/Droht-Deutschland-der-heisseste-Sommer-aller-Zeiten-10460791.html

- https://www.gruene.de/artikel/hitzewelle-2025

- https://www.t-online.de/nachrichten/panorama/wetter/id_100671794/jahrhundertsommer-2025-dieses-jahr-droht-alle-rekorde-zu-sprengen.html

- https://www.fr.de/panorama/zeigen-ein-klares-signal-sommerprognose-2025-immer-mehr-wettermodelle-kippen-die-karten-zr-93702106.html

- https://www.karlsruhe-insider.de/wetter/experten-decken-auf-sommer-2025-wird-der-heisseste-aller-zeiten-253760

- https://www.hna.de/welt/der-heisseste-sommer-aller-zeiten-sommerhitze-heute-zwoelfmal-haeufiger-1980-gab-es-hitzetage-2022-schon-16-2025-droht-zr-93808841.html

- https://www.daswetter.com/nachrichten/vorhersage/extrem-sommer-2025-startet-brutal-blitzhitze-gro-hagel-und-unwetter-rollen-uber-deutschland.html

- https://www.prosieben.de/serien/newstime/videos/warnung-steht-uns-ein-historischer-duerre-sommer-bevor-v_rb29v078hrl3

- https://www.bild.de/news/inland/kommt-jetzt-der-jahrhundert-sommer-wetterexperten-warnen-vor-hitze-682321339074dc4fc90a6bb2

- https://de.statista.com/statistik/daten/studie/5573/umfrage/monatlicher-niederschlag-in-deutschland/#:~:text=Im%20Juli%202025%20betrug%20der,im%20Vorjahresmonat%20vergleichsweise%20weniger%20Niederschlag.

- https://www.dwd.de/DE/presse/pressemitteilungen/DE/2025/20250730_deutschlandwetter_juli_news.html

- https://www.mz.de/mitteldeutschland/sachsen-anhalt/hollensommer-wo-ist-dein-sieg-4094249

- https://www.rbb24.de/panorama/beitrag/2025/07/wetter-juli-nass-regen-klima.html

- https://www.focus.de/wissen/klima/sommer-prognose-ein-reinfall-warum-das-nicht-mehr-passiert-und-hitze-zurueckkommt_c92dc94c-29f1-4716-9f17-315a12e23728.html

- https://www.t-online.de/nachrichten/panorama/wetter/id_100830034/sommer-2025-wo-bleibt-der-hitzesommer-experten-zeichnen-bild-.html

- https://www.mdr.de/nachrichten/deutschland/panorama/hoellensommer-kachelmann-wetter-prognosen-sommer-100.html

Rechtsextrem:in narrt Deutschland

Ein Meinungsdelikt brachte Sven Liebich 18 Monate Gefängnis. Kurz darauf dürfte er seine wahre Identität entdeckt haben und wurde zur Frau. In wenigen Tagen wird er ins Frauengefängnis eingewiesen werden, Staat und Medien entblößen sich dabei selbst. Sven Liebich gilt seit Jahrzehnten als bekannter Kopf der rechtsextremen Szene in Ostdeutschland, auch in der Querdenken-Bewegung wurde […]

Der Beitrag Rechtsextrem:in narrt Deutschland erschien zuerst unter tkp.at.